Apple nieustannie wzbogaca funkcjonalność iPhone’ów i iPadów. Najnowsze rozwiązania dedykowane są osobom z różnego rodzaju niepełnosprawnościami – dzięki nim ich życie ma stać się łatwiejsze. Ponadto gigant z Cupertino zapowiedział nowe funkcje odkrywania koncertów w Mapach Apple i Apple Music.

Apple zapowiada nowe funkcje ułatwień dostępu na iPhone’ach i iPadach

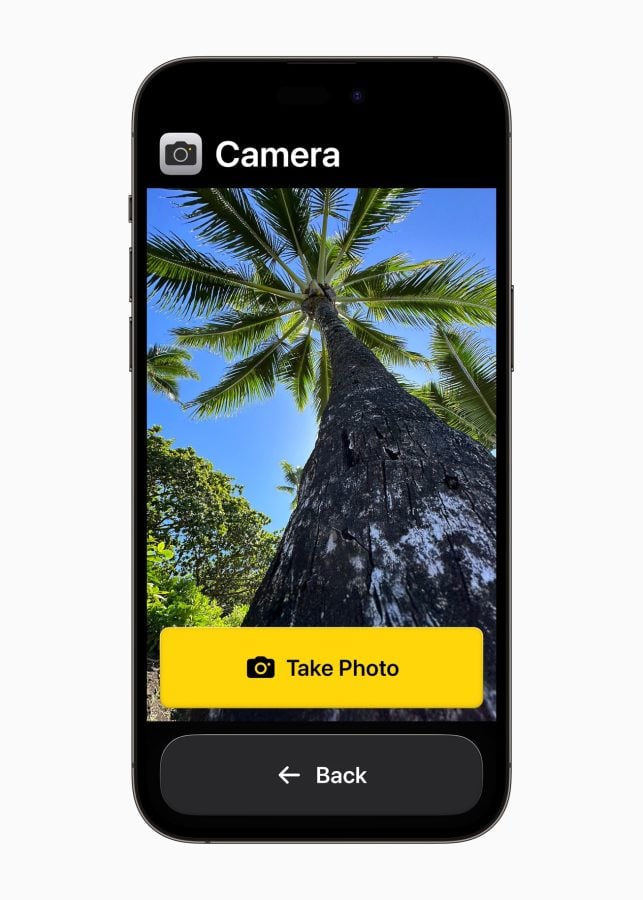

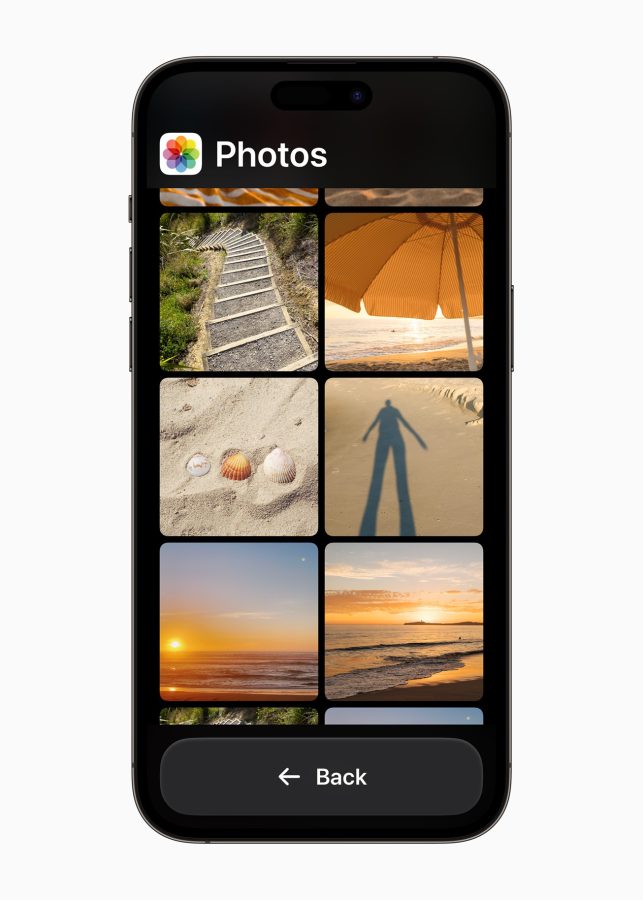

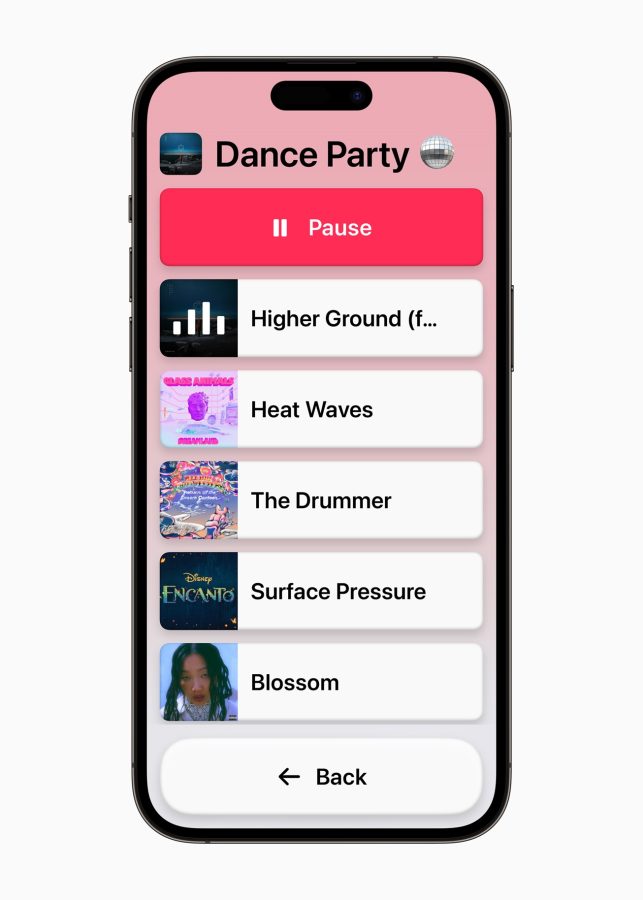

Gigant z Cupertino poinformował dziś, że jeszcze w tym roku użytkownicy z upośledzeniem funkcji poznawczych będą mogli korzystać z iPhone’a i iPada z większą łatwością i niezależnością dzięki funkcji Assistive Access. Za jej sprawą podstawowe aplikacje urządzenia, takie jak Telefon, Wiadomości, Aparat, Zdjęcia i Muzyka, będą łatwiejsze w obsłudze dzięki specjalnie zaprojektowanemu interfejsowi, który wyróżni się przyciskami o wysokim kontraście oraz dużymi ikonami i etykietami tekstowymi.

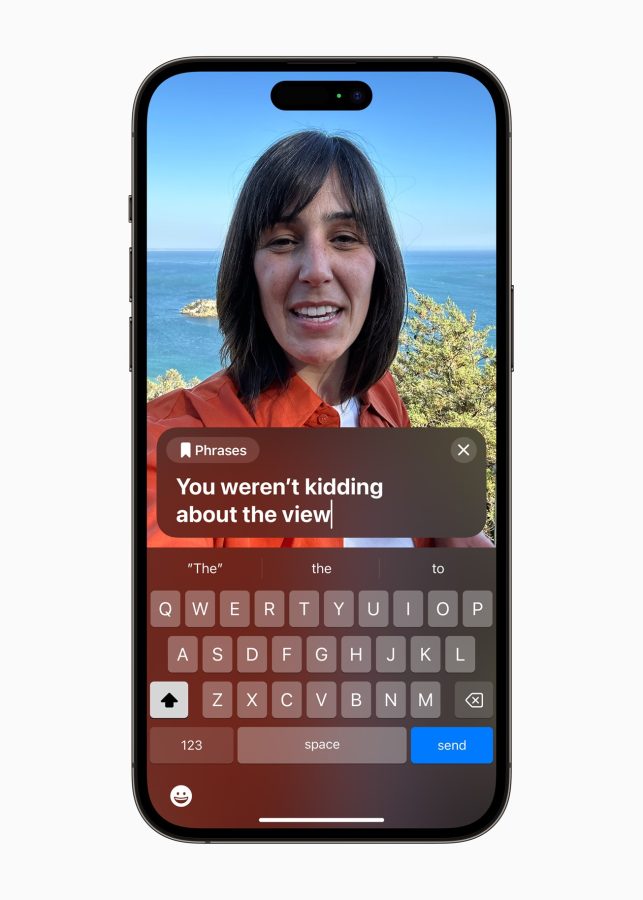

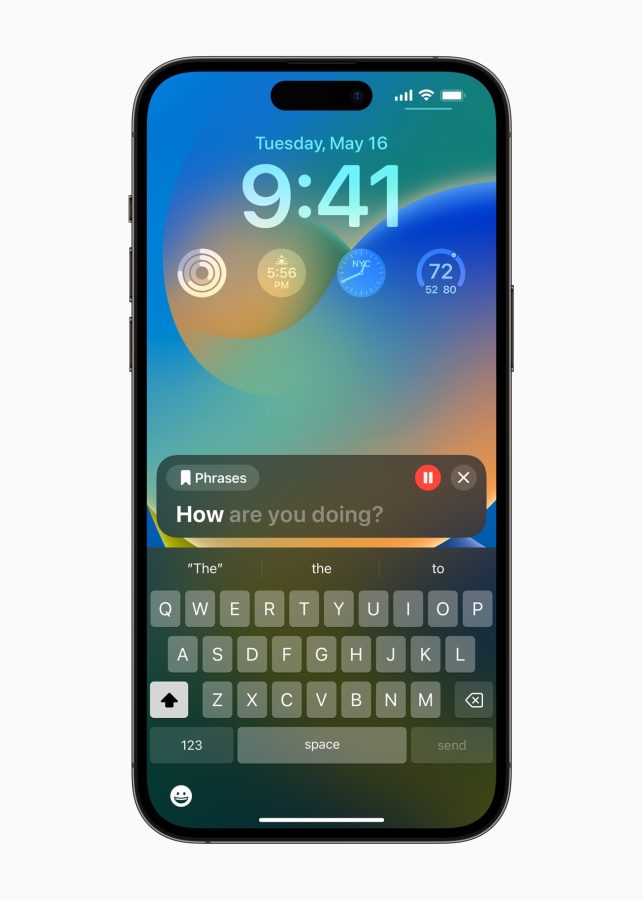

Kolejna funkcja o nazwie Live Speech umożliwi użytkowników iPhone’ów, iPadów i komputerów Mac wpisanie na klawiaturze tego, co chcą powiedzieć na głos podczas połączeń FaceTime i twarzą w twarz. Jest ona dedykowana osobom, które nie mogą mówić lub utraciły mowę z biegiem czasu.

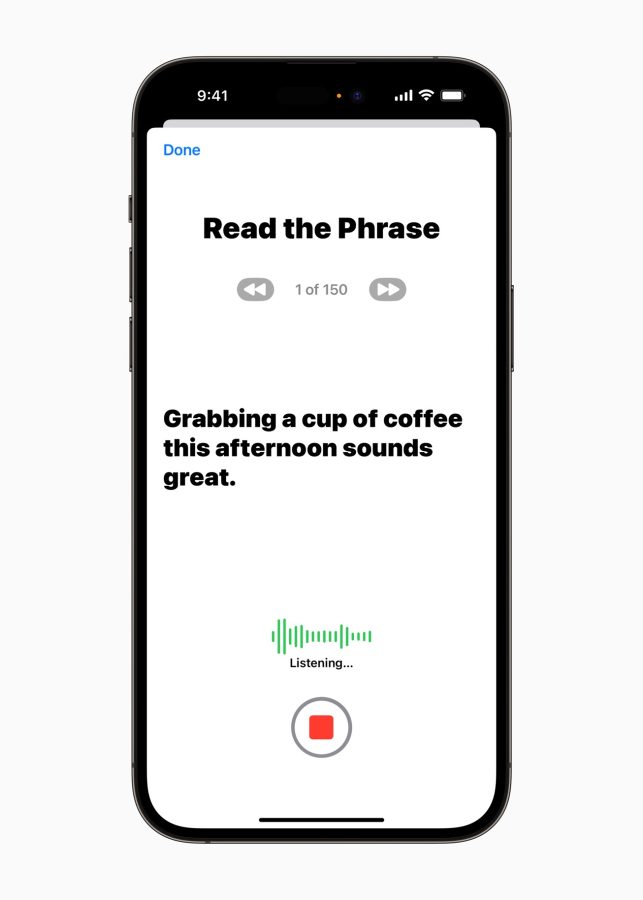

Jednocześnie Apple pomyślało o użytkownikach, którzy jeszcze potrafią samodzielnie mówić, ale grozi im utrata mowy – dla takich osób stworzono funkcję Personal Voice, dzięki której urządzenia producenta z Cupertino nauczą się ich prawdziwego głosu. W tym celu trzeba będzie czytać losowy zestaw tekstów, aby nagrać 15-minutową próbkę na iPhone’ie lub iPadzie.

Kiedy użytkownik to zrobi, funkcja Personal Voice będzie mogła rozmawiać jego prawdziwym głosem w jego imieniu w ramach Live Speech, tzn. wypowiadać wpisywane przez niego na klawiaturze słowa.

Kolejne, ogłoszone dziś przez Apple rozwiązanie, dedykowane jest z kolei osobom niewidzącym i niedowidzącym. Dzięki niemu korzystanie z urządzeń domowych ma być łatwiejsze, ponieważ funkcja Point and Speak rozpoznaje fizyczne obiekty i etykiety tekstowe oraz wykorzystuje aplikację aparatu i LiDAR. Jako przykład Apple podaje mikrofalówkę – gdy użytkownik będzie przesuwał palcem po przyciskach z napisami, iPhone przeczyta mu na głos, co jest na nich napisane.

Funkcja Point and Speak jest zintegrowana z Lupą na iPhone’ach i iPadach oraz – jak zapewnia producent – świetnie współpracuje z VoiceOver i może być wykorzystywana z innymi funkcjami Lupy, takich jak rozpoznawanie ludzi, wykrywanie drzwi i opis obrazu.

Nowe funkcje odkrywania koncertów w Mapach Apple i Apple Music

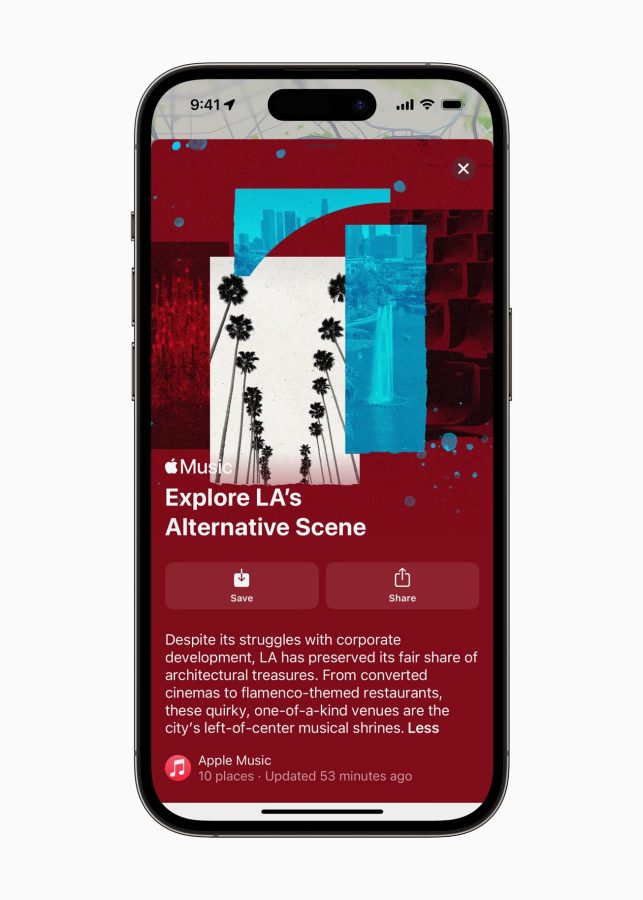

W Mapach Apple dostępnych będzie ponad 40 nowych przewodników, wskazujących najlepsze miejsca w ponad 10 miastach na całym świecie, do których zdecydowanie warto udać się na koncert – wszystkie zgromadzono tutaj. Jednocześnie w usłudze pojawią się listy nadchodzących wydarzeń muzycznych w wybranych lokalizacjach.

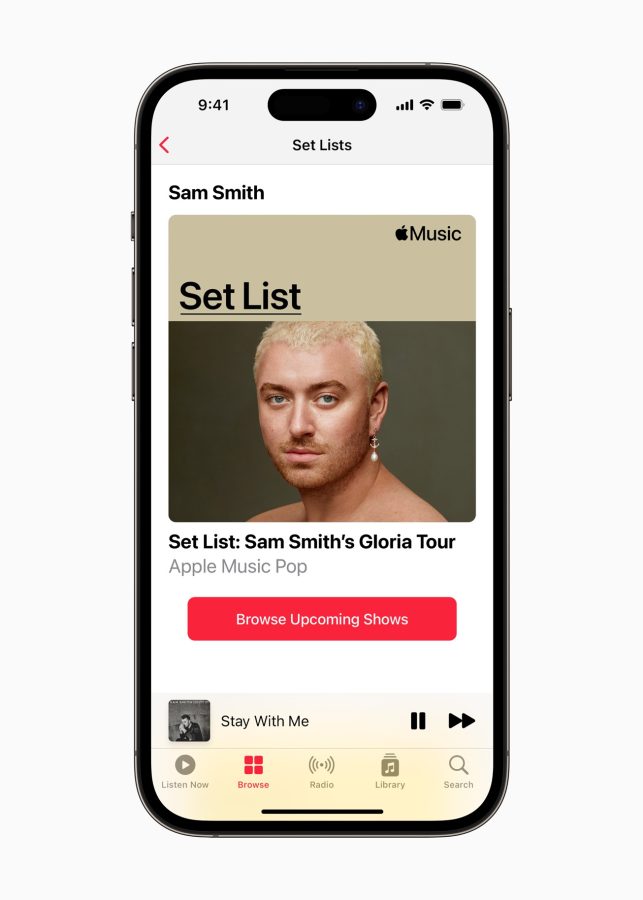

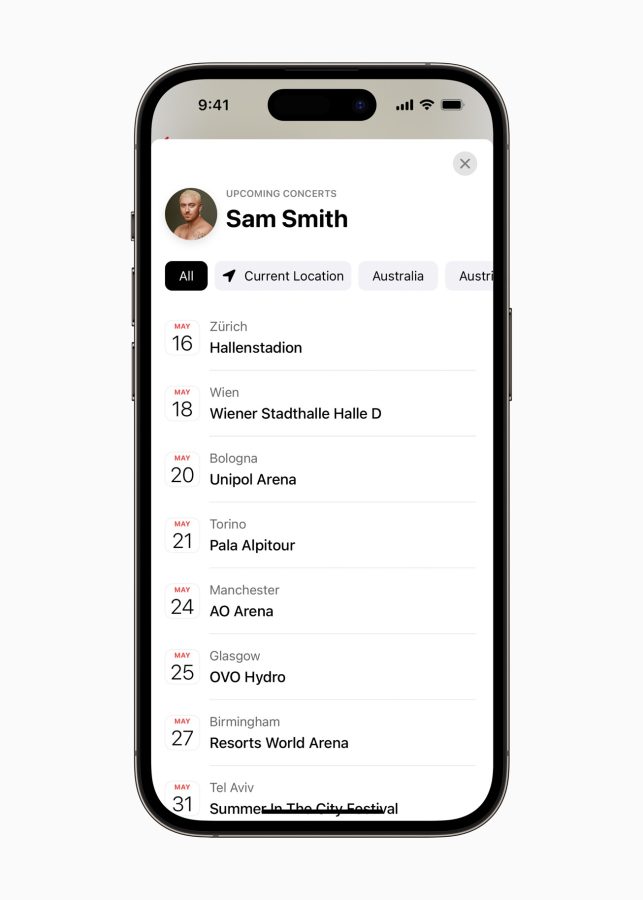

Z kolei w Apple Music została dodana zupełnie nowa przestrzeń Set Lists, która gromadzi informacje na temat wybranych tras koncertowych i pozwala fanom słuchać setlist oraz czytać o wydarzeniach. Również w tej aplikacji pojawi się funkcja, pozwalająca odkrywać nadchodzące koncerty artystów w okolicy. Set Listy są dostępne tutaj.