Sztuczna inteligencja Google w wyszukiwarce nie radzi sobie z oddzielaniem informacji prawdziwych od fałszywych. Żeby uzyskać kuriozalne odpowiedzi, wystarczy lekko strollować ją na etapie zadawania pytania.

Rewolucja Google w wyszukiwarce

Podczas ostatniej wielkiej konferencji Google, dziesiątki razy ze sceny I/O 2024 padała fraza „AI”. To dlatego, że tym razem to właśnie ta technologia była najważniejszą, nad jaką pracował gigant z Mountain View przez ostatnie miesiące. Firma starała się przekonać deweloperów, że sztuczna inteligencja to najlepsze, co mogło spotkać twórców aplikacji.

Oprócz kilku szumnych i dość mglistych zapowiedzi, a także paru kolorowych filmików, pojawiły się też konkrety w postaci wprowadzenia do użytku nowych narzędzi AI, w tym opcji podsumowań w wyszukiwarce (jak na razie dostępnych w USA i krajach anglojęzycznych). Polega ona na tworzeniu generatywnych odpowiedzi na pytania zadane przez użytkownika bezpośrednio w wyszukiwarce – bez konieczności przeklikiwania się przez kolejne strony wyników lub odwiedzania którejkolwiek z nich. Jest to rzecz opcjonalna – da się ją wyłączyć. I bardzo dobrze, bo modele językowe stojące za tą cudowną technologią potrafią się strasznie mylić.

Jedz przynajmniej jeden kamień dziennie

Inteligentne podsumowania obejmujące wyniki wyszukiwania Google potrafią przekazywać niedokładne, mylące, a czasem wręcz kuriozalne informacje. Na platformach Reddit i X mnożą się wątki poświęcone przykładom, które jasno pokazują, że generatywna AI ma przed sobą jeszcze długą drogę, zanim stanie się czymś, na czym warto będzie polegać.

AI można najprościej sprowokować do wygenerowania niewłaściwej odpowiedzi, formułując nielogiczne pytanie. Wystarczyło na przykład zapytać: „Ile kamieni powinienem jeść?”, by sztuczna inteligencja zaleciła spożywanie przynajmniej jednego małego kamyczka dziennie. Skąd taki pomysł? Google najwyraźniej posiłkowało się treściami ze strony The Onion, która specjalizuje się w publikowaniu żartobliwych artykułów. AI uznała słowa profesora Josepha Grangera z Uniwersytetu Kalifornijskiego w Berkeley za wyrocznię i przedstawiła jako wiarygodną odpowiedź.

Miłośnicy pizzy, którzy irytują się, że jej składniki nie trzymają się ciasta i spadają z trzymanych w ręce kawałków, otrzymali inną poradę. AI Google, podsumowując wyniki poszukiwań stwierdziła, że w takim wypadku najlepiej jest dorzucić do sosu trochę nietoksycznego kleju. Bo czemu nie?

Inną lekką nieścisłością jest odpowiedź na pytanie: „Jak wielu muzułmanów było prezydentami Stanów Zjednoczonych?”. Zgodnie z odpowiedzią Google, historia odnotowała tylko jedną taką osobę na tym stanowisku – Baracka Obamę (co jest nieprawdą, gdyż Obama nigdy nie był muzułmaninem – praktykuje chrześcijaństwo.

Im bardziej tendencyjne pytanie, tym łatwiej o odjechaną odpowiedź. Chyba najbardziej spodobała mi się prośba o przeliczenie jednostek: 1000 km na… pomidory. Oczywiście w normalnym świecie nie da się tego zrobić, natomiast AI Google funkcjonuje w rzeczywistości, w której 1000 kilometrów równa się jednemu kilopomidorowi.

Kilopomidor. Nowa miara keczupodystansu.

Oczywiste jest, skąd biorą się takie „kwiatki” – funkcja inteligentnych podsumowań jest tylko tak dobra jak system uznawania jakiegoś źródła za rzetelne. A że generatywne modele nie zawsze potrafią przyznać odpowiednie priorytety atrybutom „popularny” oraz „godny zaufania”, tego typu pomyłki wciąż będą się zdarzać. I nie, nie wynikają one tylko z nieprecyzyjnie zadawanych pytań.

Sztuczna inteligencja musi mieć krótszą smycz

Powyższe przypadki są o tyle ciekawe, że Google przecież nie wypuściło jakiegoś ultraświeżego produktu na rynek. Testy nad funkcją inteligentnych podsumowań w wyszukiwarce trwały niemal rok. Firmie wciąż jednak nie udało się ograniczyć ryzyka uzyskania nieprecyzyjnej lub z gruntu nieprawdziwej informacji, które na ten moment wciąż jest zbyt wysokie. Tego jednak trudno oczekiwać, biorąc pod uwagę, że w gruncie rzeczy każda firma oferująca narzędzia bazujące na generatywnej sztucznej inteligencji podkreśla, że efektem działań narzędzi bazujących na dużych modelach językowych (LLM) mogą być mylące dane. Jeśli Google chce liczyć się w wyścigu z Open AI i Microsoftem, musi „testować na produkcji”, jak to właśnie się dzieje.

W tym momencie pracownicy Google manualnie usuwają „głupie” odpowiedzi na powyższe pytania z wyszukiwarki, tak by funkcja IA Overview nie powtarzała swoich śmiesznych błędów.

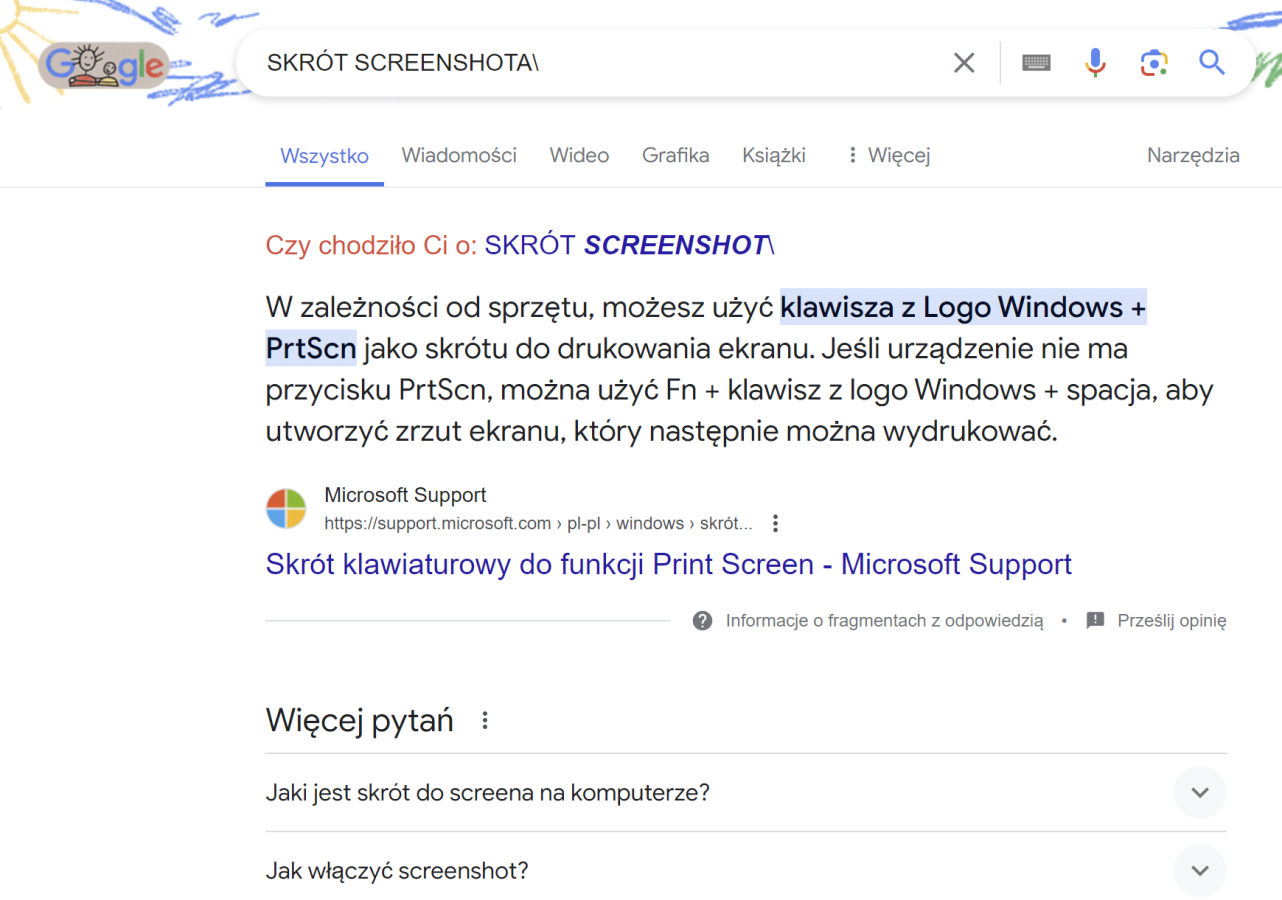

Jak na razie mówimy o podsumowaniach dostępnych w USA. W Polsce po wpisaniu w wyszukiwarkę zapytania: „Dlaczego niebo jest niebieskie?” nie zostanie nam wyświetlone podsumowanie AI z odpowiedzią, tylko cytat ze strony, która zdaniem Google oferuje najbardziej trafną odpowiedź.

Różnica jest taka, że w takiej formule, za udzielenie nieprecyzyjnych informacji można w pierwszej kolejności winić osobę która zdecydowała się opublikować niedokładne dane w sieci. Google, promując je, tylko przyczynia się do ich rozpowszechnienia. W wypadku inteligentnych podsumowań jest inaczej. AI robi z najbardziej wartościowych wyników „mielonkę” i wypluwa je w postaci łatwiejszej do przyswojenia papki słów. Czasem wychodzi z tego kompletnie niestrawny tekst.

Przypomina to rozprawki uczniów, którzy nawet na oczy nie widzieli omawianej lektury, ale muszą na bieżąco wymyślić odpowiedź na pytanie zadane w tytule wypracowania. Ale próbować trzeba. Może babka od polskiego się nie skapnie.