Wygląda na to, że poza nielicznymi wyjątkami, matryce CMOS w układzie Quad Bayer na dobre zagościły w smartfonach i to już nie tylko z najwyższej półki. Kosztem znacznego skomplikowania programowej obróbki sygnału pozwoliły one na znaczące zmniejszenie szumów przy wyższych czułościach, poprawę szczegółowości uzyskiwanych fotografii a także wprowadzenie HDR wykonywanego przy pojedynczej ekspozycji. Ostatnie innowacje w tej kategorii to 108 Mpix sensor Samsunga i autorska modyfikacja układu soczewek matrycy wymyślona przez Sony.

Układ klasyczny i układ 2×2

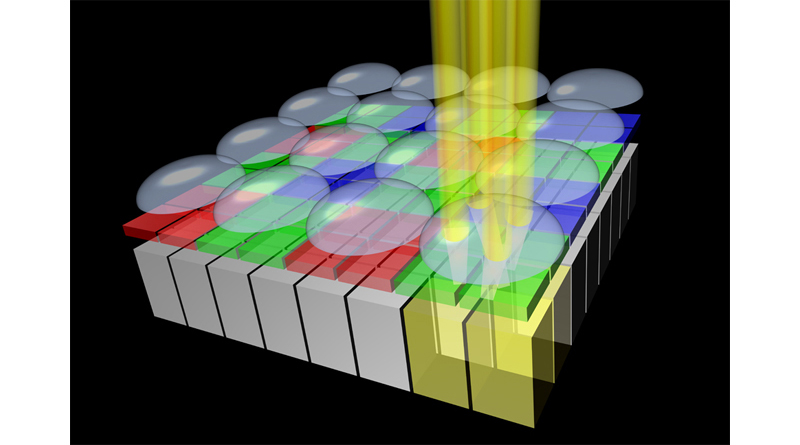

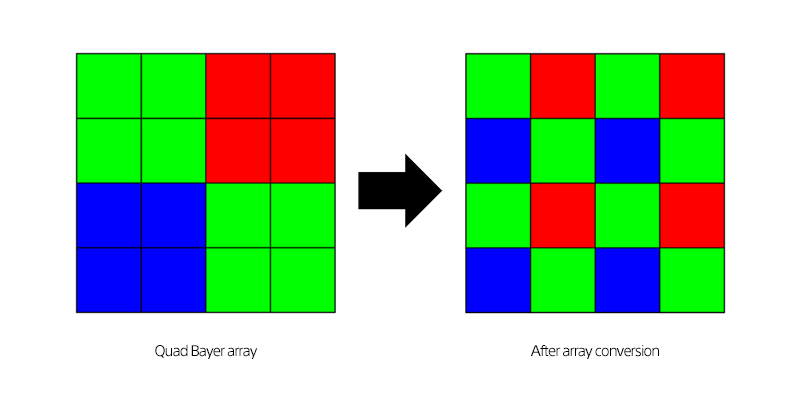

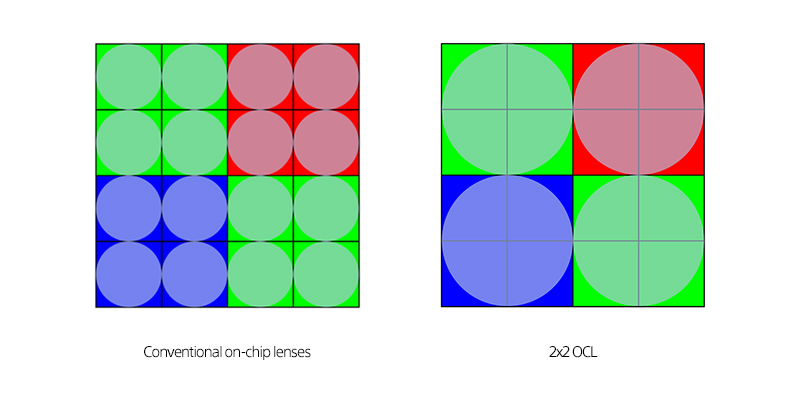

Dotychczasowe konstrukcje matryc miały bez wyjątku mikrosoczewki rozmieszczone nad każdym pikselem matrycy z osobna. Układ ten zapożyczony został od klasycznych matryc o układzie Bayera, w których sąsiednie piksele przykryte były innymi filtrami barwnymi. Sensory Quad Bayer mają jednak odmienny układ: układ Bayera tworzą nie pojedyncze fotocele, lecz czteropikselowe klastry pokryte identycznym filtrem barwnym.

Użycie odrębnej soczewki dla każdego piksela wymuszone było różnicami w rzeczywistej czułości poszczególnych komórek światłoczułych, lecz wygląda na to, że postępy w opanowaniu technologii pozwoliły na uzyskanie na tyle dużej jednorodności, by można było pokusić się o zastosowanie pojedynczej soczewki dla całego klastra – Sony nazwało tę technologię 2×2 OCL.

Użycie odrębnej soczewki dla każdego piksela wymuszone było różnicami w rzeczywistej czułości poszczególnych komórek światłoczułych, lecz wygląda na to, że postępy w opanowaniu technologii pozwoliły na uzyskanie na tyle dużej jednorodności, by można było pokusić się o zastosowanie pojedynczej soczewki dla całego klastra – Sony nazwało tę technologię 2×2 OCL.

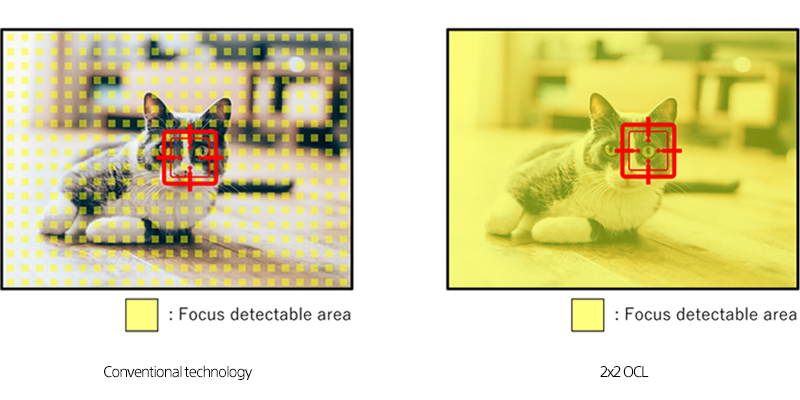

2×2 OCL pozwoliło na odejście od stosowanego dotychczas sposobu rozmieszczania na matrycy punktów detekcji fazy, odpowiedzialnych za szybki autofocus. W dotychczasowych konstrukcjach PDAF zapewniany był przez pewną ilość wydzielonych pikseli służących TYLKO do określania odległości od celu – nie brały one udziału w obrazowaniu, z konieczności zatem nie mogło być ich zbyt wiele, by nie wpływały negatywnie na jakość obrazu. Przykrycie czterech pikseli wspólną soczewką pozwala na stworzenie układu w którym każdy taki konglomerat będzie mógł służyć do fazowego nastawiania ostrości.

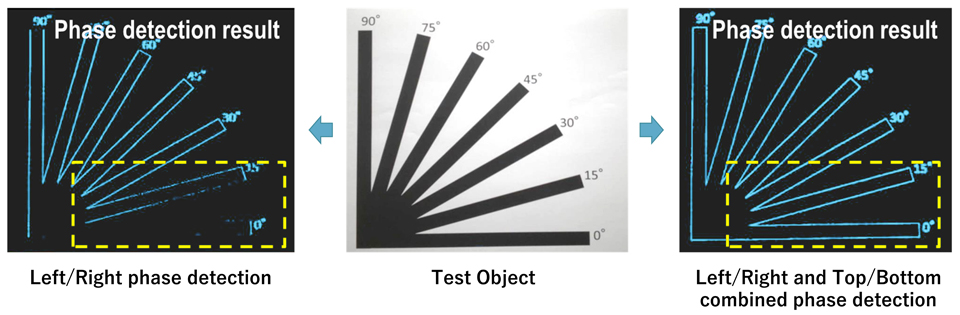

Dotychczasowe konstrukcje matrycowego PDAF miały także różną skuteczność wykrywania ostrości w zależności od obecności w kadrze konturów poziomych i pionowych. Nowa konstrukcja powinna mieć identyczną sprawność niezależnie od położenia obiektów w kadrze – podobną skuteczność miały do tej pory tylko krzyżowe punkty AF z lustrzanek cyfrowych. Wzrost sprawności powinien być szczególnie widoczny w warunkach kiepskiego oświetlenia, przy którym klasyczny autofocus dość mocno się gubi.

Pojedyncza soczewka umożliwia skierowanie na światłoczułe punkty większej ilości światła co poprawia sprawność całego układu i zmniejsza jego szumy. Wysoka jednorodność i dokładne sterowanie czułością pojedynczych pikseli pod soczewką powinno z kolei usprawnić działanie HDR z jednej ekspozycji.

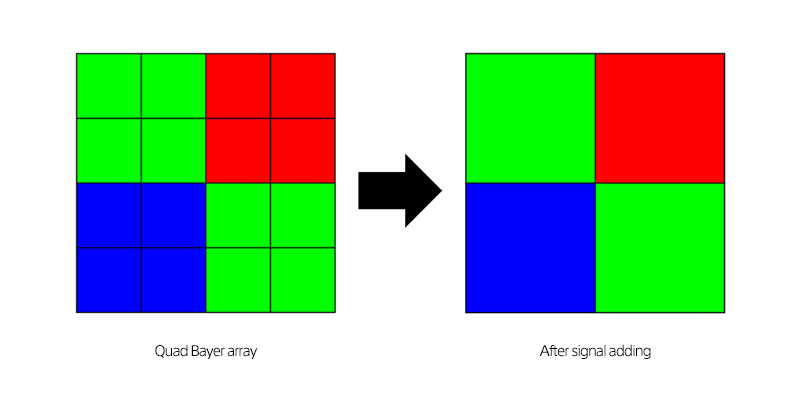

Układ z pojedynczą soczewką działa najlepiej, gdy sygnał z czterech pikseli jest łączony w jeden piksel (pixel binning), lecz nie wyklucza skorzystania z klasycznych algorytmów demozaikowania, by uzyskać obraz o pełnej rozdzielczości (warto jednak pamiętać, że nie zawsze warto się w to bawić – spora złożoność obliczeń oraz ograniczenia wynikające z układu filtrów nie pozwolą na uzyskanie znacząco wyższej ilości szczegółów) .

Warto czy nie

Teoria wygląda zachęcająco, lecz dopóki nie zobaczymy w działaniu praktycznej implementacji pomysłu, można sobie jedynie gdybać. Wprowadzony niedawno sensor 108 Mpix nie okazał się jakościowym przełomem (i mówiąc szczerze jakoś mnie to nie zdziwiło) – choć w testach wypadł rzeczywiście bardzo dobrze, to nie wygrał z sensorami o mniejszej gęstości. Także i tu dopiero po jakimś czasie dowiemy się, jaki potencjał drzemie w nowym rozwiązaniu. Czekam na to z ciekawością.