Zastanawialiście się kiedyś, dlaczego tęgie głowy tego świata tak często ostrzegają nas przed niekontrolowanym rozwojem sztucznej inteligencji? Stephen Hawking powiedział, że SI może być najgorszą rzeczą, jaka spotka ludzkość. Tylko co właściwie kryje się za tym stwierdzeniem? Czy wizja przyszłości prezentowana przez pisarzy science fiction ma szansę się urzeczywistnić i czy powinniśmy z tego powodu zaprzestać prac nad sztuczną inteligencją?

Po nieco technicznych poprzednich dwóch odcinkach cyklu nadszedł czas na zaprzęgnięcie do pracy wyobraźni. Spróbujemy się dzisiaj zastanowić, czy obecne w naszych głowach wizje zniszczenia świata za sprawą sztucznej inteligencji mogą się spełnić, czy może są tylko nadinterpretacją wynikającą z posiadania po prostu niepełnych informacji. A może prawda leży pośrodku i ostrzeżenia są racjonalne, choć dotyczą innych aspektów SI? Zacznijmy jednak od początku.

By zniszczyć życie organiczne

W wykreowanym przez studio BioWare uniwersum Mass Effecta istnieje rasa Żniwiarzy, inteligentnych maszyn, które co 50 tysięcy lat czyszczą galaktykę z wszelkich przejawów rozumnego życia. Uściślając – niszczą gatunki poprzez „przetwarzanie” ich do postaci nowego Żniwiarza. Przetwarzanie takie dodaje do umysłów maszyn wspomnienia zniszczonego gatunku, jego historię, wiedzę i kulturę. Ot, typowa space opera połączona z hołdem dla lovecraftowego Wielkiego Przedwiecznego.

Jeśli ktoś nie ukończył jeszcze pierwszej trylogii serii gier (i dodatku Lewiatan), uprzedzam, będzie mały spoiler. Cykl zagłady Żniwiarzy został zapoczątkowany przez twórców tych maszyn, przez biologiczne istoty. Ich celem było stworzenie narzędzia, które położyłoby kres wojnom toczonym między bytami żywymi i syntetycznymi. Okazało się, iż narzędzie to uznało, że najlepszym sposobem na zakończenie wojen jest synteza obu rodzajów istot. W ten sposób, teoretycznie, zachowana została „obecność” gatunków biologicznych, ale wzbogacono ją o silne strony gatunków syntetycznych. Oczywiście to wszystko wbrew woli istot żywych.

Ten motyw przewija się przez dzieła kultury nieustannie, nie dziwi mnie więc, że całkiem sporo osób ma go przed oczami, gdy mówi o zagrożeniach ze strony sztucznej inteligencji. Należy się jednak mocno się zastanowić, czy scenariusz w rodzaju tego przedstawionego powyżej w ogóle należy rozważać w kategorii zdarzeń prawdopodobnych, czy może wystarczy potraktować go jako swego rodzaju ostrzeżenie. A może jest tylko i wyłącznie wymysłem kultury i absolutnie nie ma możliwości, by scenariusz galaktycznego cyklu zagłady kiedykolwiek się spełnił?

Odpowiedź na to pytanie jest dwojaka. Nie, przy obecnym poziomie technologii sztucznej inteligencji (oraz tym, który możemy osiągnąć w najbliższych kilkunastu latach), nie ma absolutnie żadnej możliwości na to, by SI uznała, że należy zniszczyć ludzkość. Tak, sama wizja podjęcia logicznej decyzji o eksterminacji gatunku biologicznego (jako przyczyny) ma sens, ale do urzeczywistnienia się wymagałaby przede wszystkim naszej pracy nad tym. Innymi słowy, my sami musielibyśmy bardzo mocno przyłożyć się do tego, by SI nas zniszczyła.

Ostatnim aspektem jest słynna AGI, czyli generalna sztuczna inteligencja, którym to terminem środowiska naukowe określają syntetyczny byt zdolny do odczuwania świadomości. Prace nad AGI cały czas trwają; niektórzy mówią wręcz, że taka SI powstanie już za dwadzieścia lat. Nie podejmę się oceny prawdziwości tych przewidywań, ale istotne jest jedno – nie ma pewności co do tego, że pierwszą reakcją AGI na ludzi będzie wczytanie profilu „eksterminacja”. Wydaje nam się tak, bo w naszych głowach bardzo mocno zakodowany został jej wizerunek kulturowy. Tymczasem nauka wciąż nie wie, w jaki sposób działa nasza ludzka świadomość. Ignorancją jest więc zakładać konkretny scenariusz postępowania świadomości AGI. Możemy tylko spekulować.

Dezinformacja w służbie władzy

Wiemy już, że raczej nie grozi nam rychła zagłada z rąk syntetycznych istot, ale w takim razie, dlaczego Hawking, Musk i inni ostrzegają przed SI? Zanim przejdę dalej, proszę Was o obejrzenie tego filmiku; trwa tylko minutę i znacznie pomoże zrozumieć, na czym opierają się ostrzeżenia.

Poczuliście podczas oglądania emocje w rodzaju strachu, dezorientacji, zagubienia czy niepewności? Jeśli tak, to uważam, że zareagowaliście prawidłowo. Wyobraźcie sobie teraz sytuację, w której ktoś w ten sposób modyfikuje przemówienie, dajmy na to, Władimira Putina, a następnie włamuje się do amerykańskich sieci telewizyjnych i emituje je na cały świat. Wyobraźcie sobie, że słyszycie i widzicie, jak Władimir Putin oficjalnie ogłasza światu, że Rosja rozpoczyna trzecią wojnę światową. To nie jest scenariusz science-fiction; setki milionów ludzi mogłyby w taki przekaz uwierzyć, a konsekwencje trudno sobie nawet wyobrazić.

Technika, która została użyta do spreparowania powyższego filmu, jest efektem połączenia technik wykorzystywanych w kinematografii z metodami sztucznej inteligencji. W kinematografii zazwyczaj czuć jednak sztuczność – choć pojedyncza klatka z filmu Rogue One przedstawiająca Wielkiego Admirała Tarkina zdaje się mówić, że gra go sam Peter Cushing, to jednak w filmie wyraźnie widać, że to tylko animacja, a nie wskrzeszony aktor. Tymczasem na filmiku wyżej Barack Obama zdaje się wyglądać… realnie. Po dokładnym przyjrzeniu się można zauważyć pojawiające się rozmycia (wynikające z niedokładności algorytmu), ale absolutnie nikt nie wychwyci takich detali, gdy będzie oglądał samo przemówienie.

A przecież postęp nie stoi w miejscu – za rok powstanie kolejna, jeszcze lepsza generacja takich narzędzi. Słowa w usta Baracka Obamy wkładał aktor Jordan Peele, a cały eksperyment miał tylko pokazać potencjalne zagrożenia. Zadajcie sobie jednak pytanie – jaką macie pewność, że żaden z oglądanych w sieci filmów informacyjnych nie został spreparowany w ten sam sposób, ale już z zupełnie innymi intencjami? Ja nie mam absolutnie żadnej. I szczerze mówiąc, jestem tym faktem przerażony.

Autonomiczni żołnierze zagłady

Wiecie, czym są konwencje genewskie i konwencje haskie? To dokumenty, które powstały w celu „ucywilizowania” konfliktów zbrojnych, jakkolwiek ironicznie by to nie brzmiało. Pierwsze traktują o ochronie cywilów, drugie dotyczą użycia broni na wojnie. To trochę tak, jakby grupa pseudokibiców umówiła się na ustawkę, ale przedtem oświadczyła sobie, że nie będą bić się w szczepionkę. Mimo to istnienie konwencji jest raczej pozytywne; jeśli choć jedną osobę przekonają do bardziej moralnego postępowania (co znów jest ironiczne, bo mówimy o konflikcie zbrojnym), to spełniają swoją funkcję.

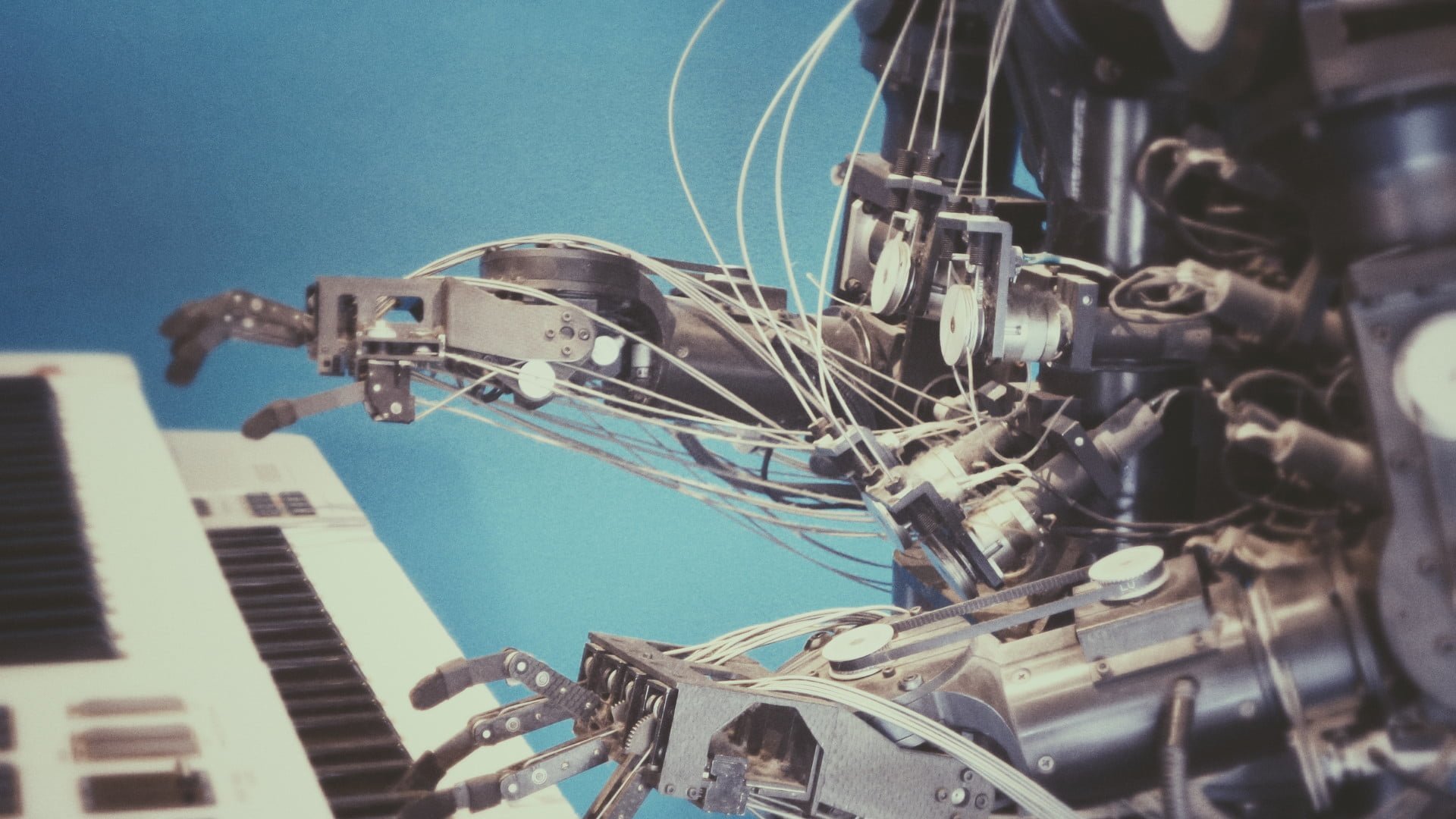

Problem leży jednak w egzekwowaniu tych konwencji. Nie sądzę, by przywódcy wywołujący wojnę przejmowali się jakimiś międzynarodowymi ustaleniami. Mimo to kwestią czasu jest, by oficjalnie powstał kolejny dokument, który regulował będzie wykorzystanie na polu walki autonomicznych wojsk. Pamiętacie stworzonego przez Boston Dynamics robota Atlas, który pokonuje przeszkody z gracją większą niż niejeden człowiek? Wyobraźcie sobie, że Atlas trzyma w ręku jakiś nowoczesny karabin, a jego sensory zmodyfikowane zostały do rozpoznawania ludzi. Nakierowanie karabinu na człowieka i naciśnięcie spustu nie przedstawia już żadnej trudności.

I to nie jest technologia przyszłości, ale coś, czym dysponujemy już współcześnie. Oczywiście koszt takiego mechanicznego żołnierza jest znaczny, ale nie warto się oszukiwać, że dla pragnących konfliktu ludzi ma to jakieś znaczenie. I choć dzisiejsza technologia nie jest jeszcze doskonała, bo być może takiego Atlasa łatwo unieszkodliwić jednym celnym strzałem, to jednak nie mam złudzeń, że przystosowanie go do działań wojennych, albo wręcz stworzenie jednostki nowej, specjalnie przygotowanej do walki, jest niemożliwe. A z pewnością jest kuszące – wizja oszczędzania własnych ludzi kosztem posyłania na front robotów niewątpliwie śni się po nocach przywódcom wojskowym i politycznym.

Tym samym, choć brzmi to nieco naiwnie, ogromna odpowiedzialność spada na koncerny zbrojeniowe i technologiczne. Tak naprawdę od nich zależy (bo przywódcy polityczni nie są przecież genialnymi inżynierami), czy sztuczna inteligencja zostanie wykorzystana przeciw innym ludziom. Ponownie nie mam jednak złudzeń – przykład chińskiego systemu oceniania obywateli (Social Credit System), któremu być może poświęcę osobny materiał, dobitnie pokazuje, że pojęcia korporacja i moralność nie idą ze sobą w parze. Myślę, że kwestią czasu jest, aż media poinformują o obecności na polu walki autonomicznego oddziału śmiercionośnych maszyn.

Sztuczna inteligencja to po prostu narzędzie

Analizując powyższe przykłady, dochodzimy do wniosku, że sztuczna inteligencja jest narzędziem, które, jak to narzędzie, może być wykorzystane do celów szlachetnych lub niecnych. Narzędziem, którego działanie polega tylko na przetwarzaniu ogromnych zbiorów informacji w sposób bardziej inteligentny. Tylko tyle i aż tyle. Nie widzę sensu w przytaczaniu większej ilości sytuacji, w których źle wykorzystana SI może działać na szkodę człowieka – dwa powyższe są wystarczająco mocne, by każdy mógł zastanowić się nad niezwykle istotnym pytaniem. Pytaniem, które brzmi…

Czy sztucznej inteligencji należy zakazać?

Cóż. Nie wiem. Z jednej strony SI już teraz ułatwia nasze życie i czyni sprzęty i systemy bardziej responsywnymi i inteligentnymi. Nieoceniony staje się także wkład SI w dziedziny naukowe – często można usłyszeć, że dalszy postęp naukowy i technologiczny bardzo mocno zależeć będzie od wykorzystywania inteligentnych obliczeń do analizy coraz to większych zbiorów danych. Rozwój oznacza zaś poprawę warunków życia, a w tej kwestii sprawa jest dość jasna.

Z drugiej strony potencjalne szkody mogą być większe niż potencjalne zyski. To właśnie przed tym ostrzegał Hawking, mówiąc, że sztuczna inteligencja może stać się najgorszym, co spotka ludzkość. Pomimo tego ten wielki umysł nie krzyczał, że SI należy zakazać, ani też nie roztaczał przed nami apokaliptycznych wizji, które spełnią się, jeśli go nie posłuchamy. Nie. Hawking, jak i inni, racjonalnie nawołują do rozsądku i kontrolowanego rozwoju.

Należy jednak zaznaczyć, że ton, w jakim wypowiadają się te tęgie umysły, nie wynika z ich naiwności, a raczej wprost przeciwnie. Myślę, że oni po prostu zdali sobie sprawę, że tej rewolucji już nie da się zatrzymać. Bo choć wiedza o SI to wąska i niełatwa dziedzina informatyki, to jednak nie jest wiedzą tajemną. W tym momencie chyba nie jesteśmy już w stanie wcisnąć przycisku STOP i zaniechać prac nad sztuczną inteligencją. Dlatego też zdrowym rozsądkiem staje się dbanie o kontrolowany rozwój, zamiast wymachiwania szabelką i grożenia apokalipsą.

Konkluzja, jaka płynie z tego nieco pesymistycznego materiału, jest prosta. Między bajki możemy włożyć przyszłe wizje zagłady ludzkości z rąk stworzonego przez nas syntetycznego gatunku, ponieważ zagrożenia płynące ze strony sztucznej inteligencji są wśród nas już teraz. Nauka dała nam narzędzie, które możemy albo wykorzystać do rozwoju i poprawy życia, albo do prowadzenia wojen, kontrolowania ludzi i pogłębiania nierówności społecznych. To zagrożenia, z którymi bez wątpienia ludzkość będzie mierzyła się w kolejnych dziesięcioleciach, a przed którymi chyba nie ma odwrotu. I tym wyjątkowo pesymistycznym akcentem zakończę dzisiejszy materiał. Do następnego!

źródła: Scientific American 11/2018, wiki / zdjęcie tytułowe z unsplash

_

#MiniSI to cykl poświęcony zagadnieniu sztucznej inteligencji, w którym, bazując głównie na literaturze, staram się rozprawić z zagmatwaniem, poplątaniem, niejasnościami i różnorakimi mitami jej dotyczącymi.