Dzięki naszym urządzeniom wszyscy jesteśmy elementami wielkiego systemu. Czy problem etyki wpisanej w maszyny i urządzenia dotyczy również smartfonów? Jak najbardziej tak.

Do tego tekstu natchnął mnie artykuł z Aeona (nr 1 w źródłach). W skrócie dotyczy on problematyki stosowania etyki przez otaczające nas maszyny w sytuacjach niejednoznacznych dla człowieka.

Niby wszyscy zgodzimy się, że tę etykę maszyny powinny mieć wdrukowaną, że zawsze powinny pilnować naszego życia i zdrowia i reagować na ich zagrożenie. Że w sytuacjach granicznych, gdy popełniamy błąd lub nie reagujemy wystarczająco prędko, nasz samochód, motor, komputer obsługujący maszyny w fabryce, powinien przejąć kontrolę, a nawet się nam sprzeciwić, by uchronić kogoś (w tym nas) od konsekwencji.

Zgodzimy się, ale zupełnie nie zdajemy sobie sprawy z konsekwencji takiej zgody.

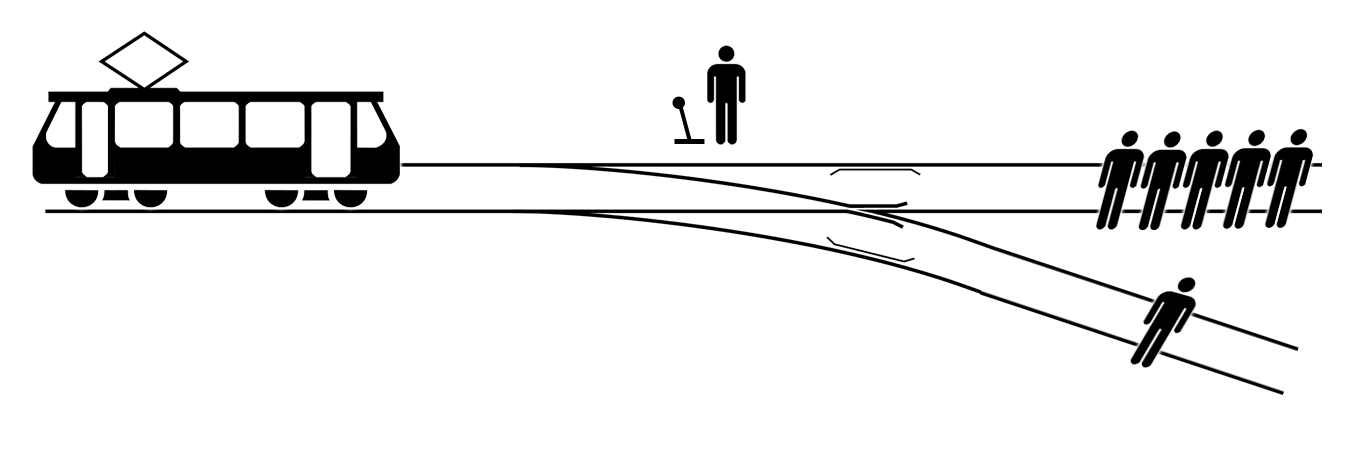

Wyobraźmy sobie sytuację opisaną w artykule – np. auta kierowanego automatycznie, które czeka wypadek, przez co natrafia na problem podobny do dylematu wagonika. Ów filozoficzny eksperyment myślowy, liczący sobie już pół wieku, ostatnio znów przewinął się przez sieć w różnych quizach i innych interaktywnych zabawach.

W skrócie dotyczy on sytuacji, w której obserwator zmuszany jest do podjęcia wyboru: czy rozpędzony wagonik bez hamulców przejedzie pięciu ludzi czy jednego. W eksperymencie człowiek musi wybrać, w którą stronę pokieruje wagonik – i jest to dla niego ogromny dyskomfort, bowiem tak czy siak, powoduje śmierć innego człowieka (lub kilku ludzi). O ile jeszcze podjęcie wyboru za cenę własnego życia lub zdrowia nie jest nam obce – zostajemy wówczas bohaterami; a czasem, gdy wybierzemy „źle” – czyli siebie i własne zdrowie kosztem cudzego – możemy zostać potępionymi (ale żywymi) wrogami publicznymi, o tyle dylemat wagonika jest okrutny, bo zupełnie nie dotyczy nas i naszego życia, lecz osób całkowicie nam obcych. W dylemacie wagonika nie mamy szansy zostać bohaterami – ZAWSZE będziemy tak czy siak mordercami, tylko w zależności od decyzji: jednej lub kilku osób.

Auto kierowane automatycznie, przez komputer, nie będzie miało takiego dyskomfortu. Nie dokona wyboru z myślą o tym, że poświęci się dla kogoś. Auto podejmie najrozsądniejszą decyzję bez wahania. I np. uratuje dwóch ludzi na pasach, kosztem Ciebie lub Twego zdrowia, bo według oprogramowania, dwa życia są ważniejsze niż jedno życie.

Oczywiście, nie zdajemy sobie z tego tak od razu sprawy. Nie podoba się nam przekazanie takiej władzy maszynom i oczywiście jest to całkowicie głupie, ponieważ maszyna zawsze podejmie wybór najlepszy, neutralnie i bez wpływu emocji. Tyle, że najlepszy społecznie, nie najlepszy dla nas. Maszyna kierująca autem nie pozwoli nam zostać pośmiertnymi bohaterami, ani też nie uczyni nas potępionymi. Dla maszyny my i inni, będziemy szeregiem zmiennych, które w danej chwili uzbierały mniej lub więcej punktów w jakimś szybkim teście. Już nawet nie szczęście, rzut kostką, lecz tylko i wyłącznie twarde, policzalne dane zadecydują czy wyjdziemy z tego, czy nie.

Twój identyfikator

Każde urządzenie, jakie nosimy przy sobie, w tym oczywiście smartfon, jeśli tylko wpięte jest w sieć, jest również naszym identyfikatorem. Posiada bowiem czy to ID karty sieciowej, unikalny numer urządzenia, czy – jeśli dodatkowo jest spersonalizowane – informację, że to właśnie JA jestem w danym miejscu, tu i teraz. W sytuacji auta autonomicznego, jego komputer – oraz wszystkie inne, łączące się z nim – wiedzą, że jedzie nim człowiek, który zalogował się do systemu takim a nie innym loginem/głosem/kciukiem/tokenem i że urządzenie należy do kogoś konkretnego. Niech to będzie John Smith i niech John jedzie tym swoim autem, gdy zdarzy się coś.

Oczywiście taka wiedza to niesłychane udogodnienie – urządzenia mogą natychmiast zgłaszać np. problemy ze zdrowiem (choćby np. atak serca na środku autostrady) odpowiednim służbom. Urządzenia nie będą robić sobie żartów. Będą zawsze znać miejsce, w które trzeba dotrzeć i podadzą szczegółowo wszystkie potrzebne informacje. Lekarz w karetce pogotowia, jadąc do wypadku, będzie np. mógł monitorować odgłosy z kabiny rozbitego auta, choćby oddech poszkodowanego, a jeśli ten nosi odpowiednie urządzenie na swoim ciele, choćby smartwatcha – także tętno, ciśnienie krwi, itp (jeśli oczywiście urządzenie ma takie możliwości). Lekarz będzie mógł się skontaktować z Johnem i poradzić mu, co zrobić, jak zadbać o siebie do chwili przybycia pomocy. Strażak udzieli mu informacji, jak – nie mając jednej nogi – John może wydostać się z zaciętego auta, bo zostało jeszcze tylko 76 sekund do zapłonu paliwa…

Z drugiej strony informację o tym, że John Smith zginął w wypadku na autostradzie 66, jego żona, szef i ubezpieczyciel, policja, szpital oraz najbliższy zakład pogrzebowy i złomowisko dostaną kilka sekund po wypadku. Taka prędkość, taki kąt uderzenia, taki rozkład mas, takie wektory… Brak oznak życia Johna Smitha. Lub też John umrze za 3 minuty z upływu krwi. Karetka dojedzie za 8. Za późno. Zatem nie będzie się spieszyć. Po 3 minutach pojawia się obok miejsca zdarzenia przypadkowe auto? Nikt nie wysiądzie i nie pobiegnie do wraków w nadziei ratunku, bo automat powie człowiekowi, że już jest za późno. Automatyczne systemy kontroli zmodyfikują ruch na odcinku, w którym nastąpił wypadek, by unikać dyskomfortu innych podróżnych. Komputery przyciemnią okna, by nie widać było miejsca tragedii.

A jeśli autu grozi eksplozja, a system oceni, że John nie ma szans, nie połączy go ze strażakiem, ale psychologiem. Lub z kapłanem jego religii, w trybie awaryjnego ostatniego namaszczenia online.

Roboty piszące newsy w mediach info o wypadku wrzucą najpóźniej kilka sekund po otrzymaniu i weryfikacji informacji od innych robotów. Wszystko szybko, profesjonalnie i beznamiętnie. ID użytkownika i jego urządzeń zostanie zmodyfikowane na „wyłączony z systemu” a dane zarchiwizowane. Na social mediach Johna zostanie wygenerowany systemowy komunikat o zakończeniu obsługi tego konta z powodu braku użytkownika w rejestrze.

Twoja biografia

Urządzenie wie o nas bardzo wiele – i sieć, w którą jest wpięte, wie co najmniej tyle samo. W sytuacji wypadku Johna Smitha, smartfon po zebraniu informacji od innych urządzeń – lub auto po zaciągnięciu kontaktów ze smartfonu – może powiadomić zarówno jego żonę, dzieci, rodzinę, jak i kochankę czy kochanka. I 5 osób z Twittera czy Facebooka, z którymi miał najwięcej interakcji w ciągu ostatnich 5 lat. Urządzenie może wiedzieć, jaką John ma grupę krwi, na jakie leki jest uczulony i czy będąc 4 godziny temu w restauracji zamówił coś, co może wejść w jakąś reakcję z colą z automatu sprzed pół godziny. Lekarz przybędzie na miejsce doskonale przygotowany. Urządzenie będzie wiedziało, kto z bliskich lub znajomych Johna jest najbliżej szpitala, do którego będzie odwieziony, i czy taka osoba będzie miała czas, czy też siedzi na cotygodniowej całodziennej naradzie w swoim korpo i nie wyjdzie z niego prędzej.

Ale też w sytuacji dylematu wagonika, Wielki Komputer może wrzucić na szalę algorytmu nie tylko liczbę potencjalnie uratowanych żyć, lecz i ich jakość. Może tych pięciu ludzi na pierwszym torze to złoczyńcy, a ten jeden na drugim jest doskonałym lekarzem? Może złoczyńcy mają szansę na resocjalizację a lekarz jest świetny, ale ćpa i się stacza? Może któraś spośród potencjalnych ofiar planuje zamach terrorystyczny? Nie płaci alimentów? Zdradza żonę? Bije dzieci? Kłamie i oszukuje w serwisach randkowych? Może ktoś od roku nie chodzi na siłownię, ma nadwagę i jest opryskliwy? Może któraś z ofiar ma raka i i tak umrze w ciągu 6 miesięcy? Może któraś oszukuje system podatkowy? Może któraś w ciągu ostatnich 2 lat w social mediach ma więcej „kciuków w dół” niż „w górę”, co coś przecież oznacza? Może ma mało znajomych – a więc ma problemy z socjalizacją?

System bardzo szybko oceni wszystkie zmienne i podejmie decyzję, kto będzie bardziej wartościowy i co będzie mniejszym złem. I spowoduje, że auto Johna Smitha np. nagle skręci w bok i wbije się w grupę staruszek na przejściu dla pieszych, by ocalić przechodzącego obok noblistę od szczepionek. John zostanie potępiony, choć nie miał na to wpływu. Lub też wypuści na Johna TIRa, by nie wpadł w auto z kobietą w ciąży, dlatego, że John, pomimo skłonności do autodestrukcji, nie chodził od roku do psychologa, nie brał leków i groziło to i tak jego samobójstwem w ciągu najbliższych 3 lat. I John zostanie bohaterem, choć nie miał na to wpływu.

A jeśli decyzja okaże się niepopularna lub dyskusyjna, technicy wprowadzą update do oprogramowania.

Czynnik oceny

Nikt nie wie o nas tyle, ile wiedzą o nas nasze urządzenia, w tym – być może najbardziej – smartfony właśnie. W sieciach, do których są one podpięte, funkcjonujemy jako bazy danych, zawierające nasze zwyczaje codzienne, miejsca, które odwiedzamy, alkohole, jakie pijemy, całe mnóstwo naszych wyborów, działań, przekonań. Sieci wciąż się rozwijają, łączą i syntezują swe dane. Przyłączenie starych baz danych Twej uczelni spowoduje, że wkrótce do Twego rozproszonego katalogu dołączą oceny semestralne i uwagi z dzienniczków. Algorytm nauczy się kiedyś rozpoznawać Twoje cechy opisane w młodzieńczych wierszach Twojej sympatii, wrzuconych do jakiejś grupy dyskusyjnej o poezji. Robot znajdzie Twoje komentarze w różnych serwisach – rozpozna je nawet, jeśli pisałeś z różnych IP i pod różnymi nickami. Wszystko to dobuduje kolejne zmienne do Twego profilu. I to już naprawdę mało ważne, czy do tych danych będzie miała dostęp jakakolwiek agencja bezpieczeństwa, czy operator sieci kablowej, czy Zenon informatyk, czy maszyna oceniająca. Jak na razie to ogrom wiedzy w większości zupełnie bezużytecznej. Owszem, system serwowania reklamy wykorzystuje jej część. Owszem, agencje bezpieczeństwa, policja i inne służby też je wykorzystują, jeśli ktoś jest dostatecznie naiwny, by pisać o swoich niecnych planach, żądzach i dokonaniach w sieci lub chociażby wyszukiwać w google, jak pozbyć się ciała.

Ale w chwili, gdy maszyny wokół nas zaczną działać autonomicznie i uzyskają etykę, będą zmuszone do podejmowania działań opartych się na ocenach – i my i nasze bazy danych będziemy również podlegać tym ocenom, jako całość. Porno oglądane 20 lat temu, zbyt wiele śmiesznych kotów w stosunku do artykułów o głodzie w Afryce, kilka bezsensownych lajków na kilku bezsensownych stronach internetowych może zadecydować o tym, że zostaniemy ocenieni gorzej niż ktoś inny. Jako gorszy człowiek niż inny.

Którego ból lub śmierć będzie mniejszym złem.

Źródła:

1. Can we design machines to make ethical decisions?

2. Is One of the Most Popular Psychology Experiments Worthless?

Źródła ilustracji:

1. Obrazek ilustracyjny: Phil Naranjo, flickr, licencja CC-BY

2. McGeddon – Own work, CC BY-SA 4.0, wikipedia

3. Helena Jacoba, flickr, licencja CC-BY

4. Dean Hochman, flickr, licencja CC-BY