Problem mowy nienawiści w sieci nie jest nowy, a tym bardziej w żaden sposób nie ominął YouTube’a. Google zamierza jednak z nią walczyć, wprowadzając zmiany i nowe narzędzia na swojej platformie by poprawić bezpieczeństwo w społeczności oraz zwalczać agresję słowną.

Wsparcie dla mniejszości

W opublikowanym poście na blogu YouTube’a, Google podkreśla, że chce zapewnić możliwość kreowania różnorodnej i bezpiecznej społeczności, by twórcy ze wszystkich środowisk mogli odnaleźć się na platformie, tym samym tworząc miejsce przyjazne dla każdego użytkownika. Skupiają się tutaj głównie na sekcji komentarzy, która przechodziła różne przemiany, a twórcy treści zyskiwali nowe narzędzia pozwalające im zarządzać komentarzami pod filmami bardziej sprawnie. Tym razem gigant idzie jeszcze o krok dalej.

Wkrótce twórcy dostaną dostęp do nowej funkcji w YouTube Studio, która odfiltruje komentarze automatycznie oflagowane jako wymagające sprawdzenia, ze względu na swoją potencjalną wulgarność lub krzywdzący wydźwięk. Pozwoli to YouTuberom na całkowite zignorowanie takich treści, dzięki czemu nie będą musieli ich czytać, jeśli sami nie wyrażą chęci ich przejrzenia. Dodatkowo zostaną udostępnione odpowiednie narzędzia do moderowania komentarzy, co ma ułatwić proces ich sprawdzania.

Pomyśl, zanim wyślesz

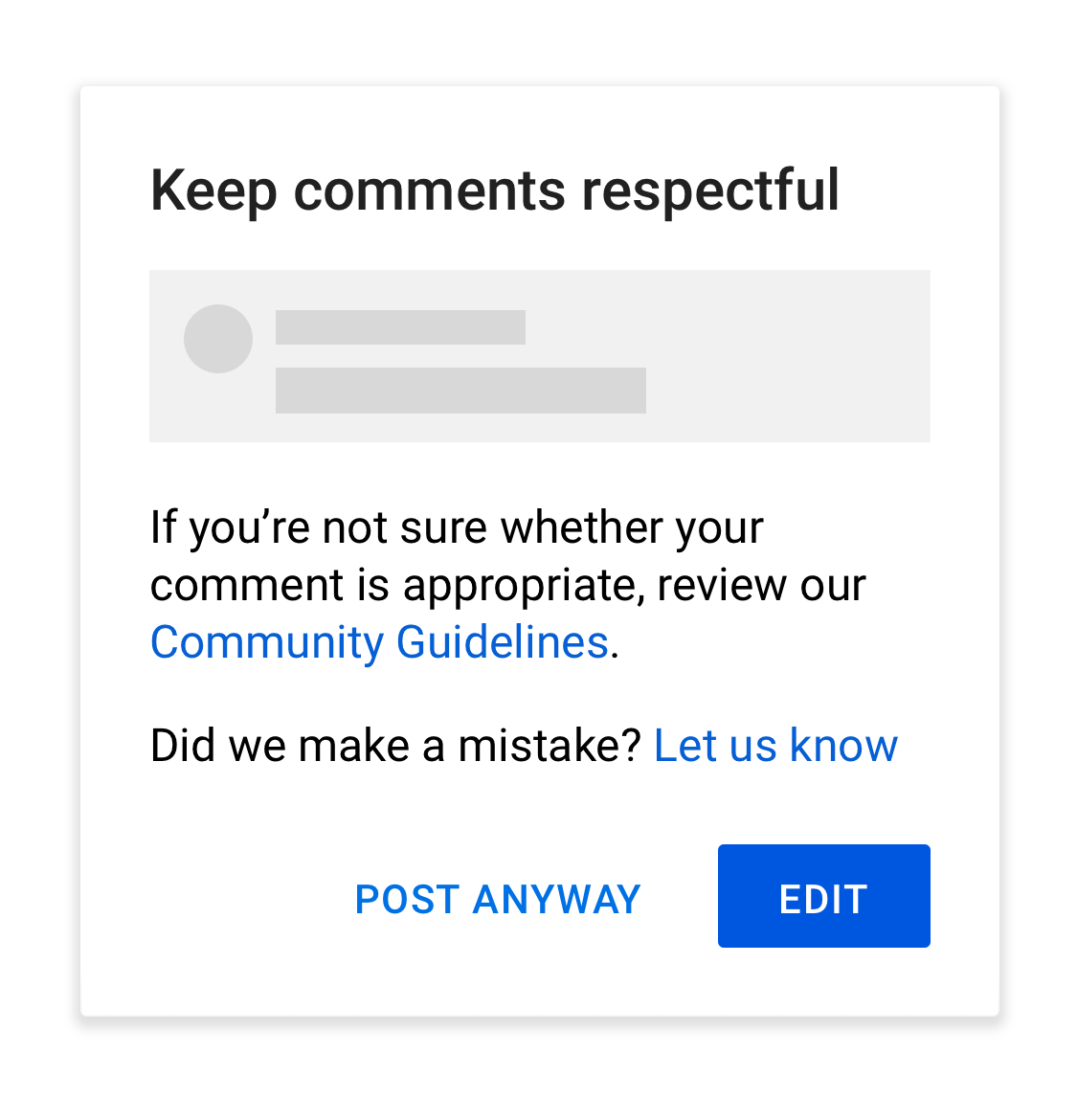

Dodatkiem do tych zmian, który wpłynie nie tylko na twórców, ale również na autorów komentarzy, jest nowe ostrzeżenie przed zamieszczeniem potencjalnie obraźliwego wpisu. Jeśli algorytm wykryje wulgarne lub rasistowskie wyrażenia w treści, którą chcemy zamieścić pod czyimś filmem, ostrzeże nas, że może ona łamać Standardy Społeczności YouTube. Będziemy mogli wtedy cofnąć się do edycji komentarza lub zamieścić go mimo to.

Aby dopełnić cały system wykrywania i zapobiec wielu fałszywym alarmom, właściciele platformy w przyszłym roku wdrożą dobrowolne kwestionariusze, które twórcy będą mogli wypełnić, zaznaczając w nich informacje m.in. o swojej płci, orientacji seksualnej czy rasie i pochodzeniu etnicznym. Te dane pozwolą udoskonalić systemy bezpieczeństwa komentarzy i zarówno zwalczać mowę nienawiści, jak i dostosować system indywidualnie pod każdego twórcę, niezależnie czy jest to kanał o modzie i kosmetykach czy zwykły podcast lub talk-show.

Statystyki mówią same za siebie

Twórcy wpisu na blogu YouTube podkreślają, że wprowadzane sukcesywnie narzędzia do walki z mową nienawiści pozwalają im na lepszą ochronę użytkowników na swojej platformie. Od początku 2019 roku liczba usuwanych dziennie komentarzy szerzących nienawiść zwiększyła się 46-krotnie. W ostatnim kwartale zaś, zamkniętych z powodu naruszenia zasad zostało 1,8 miliona kont, z czego ponad 54 tys. kont zamknięto za mowę nienawiści. Jest to wartość trzykrotnie większa niż rok wcześniej, kiedy zaktualizowane zostały zasady platformy co do treści szerzących nienawiść.

Przed YouTubem jeszcze długa droga by stać się miejscem bezpiecznym dla każdego, ale podejmowane kroki z pewnością przyczynią się do zmniejszania ilości obraźliwych treści zamieszczanych na platformie. Być może okienko z ostrzeżeniem zmusi komentujących do refleksji i sformułowania myśli bez stosowania mowy nienawiści.