Uczenie maszynowe nie zawsze znajduje zastosowanie w wielkich, szumnych projektach. Czasem najlepiej sprawdza się, eliminując drobne błędy i wprowadzając małe poprawki, które w subtelny sposób polepszają wrażenia z użytkowania usługi czy aplikacji. Pochylimy się nad przykładem Twittera i tym, jak sieci neuronowe automatycznie przycinają załączone do postów zdjęcia tak, by w miniaturach były widoczne ich najciekawsze części.

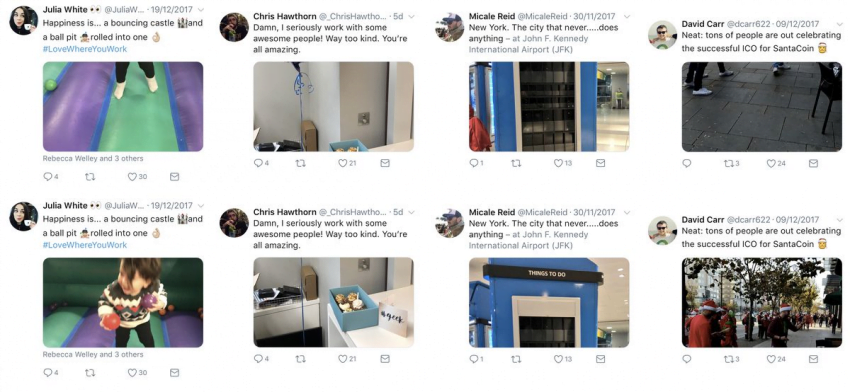

Ileż to razy, udostępniając jakieś zdjęcie na Twitterze, wydawało się, że będzie świetnie wyglądać na tajmlajnie, a po publikacji okazywało się, że aplikacja po prostu wyśrodkowała grafikę w podglądzie, niszcząc cały efekt? Teraz takie sytuacje powinny być coraz rzadsze dzięki wykorzystaniu uczenia maszynowego.

Zaczęto od rozpoznawania twarzy i takiego orientowania zdjęcia, by w miniaturze zawsze było to, co najważniejsze – czyli właśnie czyjaś uśmiechnięta buźka. Algorytmy nie potrafiły jednak wychwycić najistotniejszych szczegółów z grafik bez postaci. Metoda ta nie działała w przypadku zdjęć scenerii, pejzaży, obiektów oraz – co najważniejsze – kotów.

Żeby zdefiniować, na co człowiek będzie chciał spojrzeć w pierwszej kolejności, wykorzystano dane z akademickich badań dotyczących tego, na jakich elementach obrazu zwykle spoczywa nasz wzrok w pierwszej kolejności. Zebrane informacje wykorzystano do szkolenia algorytmów Twittera przycinających zdjęcia.

By nie skupiać się na niepotrzebnych detalach punktowo, specjaliści opracowujący tę technologię zmniejszyli nieco wymagania dla nadających się do przycięcia obrazków. Dzięki temu sieć neuronowa nie była tak obciążona poszukiwaniami najbardziej interesującego szczegółu, a efekty okazały się zadowalające. W ten sposób można wykryć ważne elementy w czasie rzeczywistym, w momencie publikacji.

Nowa funkcja jest obecnie wdrażana w wersji webowej Twittera oraz w aplikacjach na iOS i Androida. Kiedy więc następnym razem wrzucisz zdjęcie kota, na którym twój pupil nie będzie w centralnej części fotografii, sieci neuronowe powinny oddać mu jego należne miejsce. Tylko tyle i aż tyle :)

źródło: The Verge