Zapraszam Was, drodzy Czytelnicy, w podróż do krainy FPS-ów, wymaksowanych ustawień graficznych oraz chorych (jak na dzisiejsze czasy) cen. Przed Wami recenzja karty Gigabyte GeForce RTX 5080 Aorus Master!

Trochę zajęło mi przygotowanie niniejszego materiału (tak, wiem ile czasu minęło od premiery tego GPU), ale wszystko przez mały problem, który diagnozowałem dłuższą chwilę. Zaraz jednak wszystko, krok po kroku, Wam opowiem.

Zacznijmy od podania podstawowych informacji, na jakiej platformie karta była testowana:

- procesor: Intel Core i9-14900K 3.2 GHz (6.0 GHz w trybie turbo),

- chłodzenie procesora: Deepcool Mystique 360 mm,

- pamięć RAM: G.Skill Trident Z5 RGB, DDR5, 48 GB, 7200MHz, CL36,

- płyta główna: Gigabyte Z790 AORUS MASTER DDR5,

- zasilacz: Asus ROG Thor 1200W 80 Plus Platinum z wbudowanym watomierzem,

- dyski SSD: Samsung 980 Pro 2 TB PCIe Gen 4.0 x4, NVMe, Kingston 2TB M.2 PCIe Gen4 NVMe KC3000,

- system operacyjny: Windows 11,

- monitor 32″ Acer Predator X32FP Gaming monitor 32″ 4K Mini LED,

- mysz Razer DeathAdder V3 Pro Black,

- klawiatura Glorius GMMK 3.

A teraz przyjrzyjmy się temu, co skrywa w sobie Gigabyte GeForce RTX 5080 Aorus Master:

- rodzaj złącza: PCIe 5.0 x16,

- pamięć: 16 GB,

- rodzaj pamięci: GDDR7,

- szyna pamięci: 256 bit,

- typ chłodzenia: aktywne,

- liczba wentylatorów: 3,

- HDMI 2.1b – 1 szt.,

- DisplayPort 2.1a – 3 szt.,

- liczba obsługiwanych monitorów: 4,

- obsługiwane biblioteki: DirectX 12, OpenGL 4.6,

- złącze zasilania: 16 pin,

- rekomendowana moc zasilacza: 850 W,

- wymiary: 360 x 150 x 75 mm (długość x szerokość x wysokość).

Cena Gigabyte GeForce RTX 5080 Aorus Master 16 GB GDDR7 w momencie publikacji recenzji to około… (aż trudno mi się to pisze): 7399 złotych.

Pierwsze wrażenia

No nie powiem – z roku na rok coraz bardziej Gigabyte… przepraszam, Aorus, mnie zachwyca! W tym roku w opakowaniu sprzedażowym znajdziemy nawet… dodatkowy wentylator (nie spodziewałem się tego). Ale czy jest potrzebny? O tym później! W pudełku jest też podpórka pod kartę oraz przejściówka 12vhpwr na 3x 6+2 pin (o niej więcej za chwilę, bo to jest temat, który muszę oddzielnie poruszyć).

Co do wykonania samej karty, muszę się już chyba przyzwyczaić – plastik, plastik i jeszcze raz plastik (jak w zeszłym roku). Ale muszę przyznać, że świetnie imituje malowany metal i, co najważniejsze, jest bardzo dobrej jakości! Nie zauważyłem, by łapał jakoś nadmiernie odciski palców.

Największą zmianą w tegorocznej prawie topowej karcie Aorus jest wbudowany wyświetlacz. A jak on działa? Najlepiej będzie, jak Wam to pokażę – ale do tego wrócimy przy aplikacji do zarządzania naszym GPU.

Dodam jeszcze, że Gigabyte GeForce RTX 5080 Aorus Master 16 GB idzie na wojnę z temperaturami. Producent zastosował tutaj ciekły metal, który ma skutecznie odprowadzać ciepło z naszego procesora graficznego. Jak skutecznie to działa? Oczywiście zobaczycie w grach.

Dlaczego tak długo czekaliście na ten tekst? Jest winowajca (i nie jest nim autor)

Karta jest w moich rękach już od ponad miesiąca i testowałem ją już… prawie 2 razy!

Na dobre zainteresowałem się nią po kilku dniach intensywnego użytkowania – pierwsze benchmarki, zliczanie FPS-ów i tak dalej (czyli wszystko to, co widzicie w końcowym efekcie). Niestety, po ponad połowie wykonanych różnych testów karta chodziła bardzo nieregularnie (od randomowych spadków FPS-ów przez problemy ze stabilnością peceta, kończąc finalnie na tym, że – aby móc odpalić komputer – musiałem go uruchamiać 5 razy i modlić się, by w końcu po pracy kilkusekundowej nie łapał freeza (serio, nie żartuję).

Dość długo poszukiwałem przyczyny tych dziwnych usterek i, po wylaniu wiader frustracji, i wyrzuceniu z siebie masy niecenzuralnych określeń (moja żona i zapewne sąsiedzi świadkami moich niegodnych słów), udało mi się – przez totalny przypadek – odkryć, co było winowajcą. A był nim… kabel 12vhpwr 3x 6+2 pin. A dokładniej fakt, że ów kabel deliaktnie wypinał się z gniazda karty (za każdym razem przed uruchomieniem peceta musiałem poprawiać połączenie).

Nie będzie tu żadnej wybuchowej puenty – po prostu ten kabel wywaliłem, a w jego miejsce trafił 12vhpwr z RTX 4090, który zakończony jest 4x 6+2 pin. I – tak – to całkowicie wyeliminowało problem. Karta zaczęła działać tak, jak bym się tego po niej mógł spodziewać. Mała pierdoła, a ile problemów…

Kultura pracy

W skład chłodzenia wchodzą trzy wentylatory z systemu “Hawk Fan” oraz jeden dodatkowy, montowany bezpośrednio na tyle karty. Niestety, w moim PC nie jestem w stanie wykorzystać tego dodatku, gdyż kartę mam montowaną wertykalnie (ot, taki mój mały kaprys (niedługo planuję zbudować coś bardziej “tradycyjnego”, wtedy z miłą chęcią dopiszę kilka zdań do tego tekstu czy można odczuć różnicę w pracy GPU). Dodajmy jeszcze, że jest to system półpasywny, a dokładnie Windforce cooling system, który wyłącza wentylatory, gdy obciążenie GPU jest poniżej 50%.

Jak już wspominałem, producent zastosował w tegorocznym modelu ciekły metal zamiast normalnej pasy termoprzewodzącej, która ma zapewnić odprowadzanie ciepła na poziomie klasy serwerowej. Jak to rozwiązanie sprawdza w grach? O tym za chwilę, tymczasem zobaczmy, jak bardzo układ słychać podczas pracy w trzech ustawieniach – 50% 75% i 100%:

- 50%: 44,8 dB,

- 75%: 50,9 dB,

- 100%: 60,1 dB.

Z doświadczenia mogę powiedzieć, że to naprawdę niezłe wyniki. Biorąc pod uwagę zeszłoroczne testy RTX-a 4080 SUPER GAMING OC mogę stwierdzić, że wyniki w głośności są porównywalne.

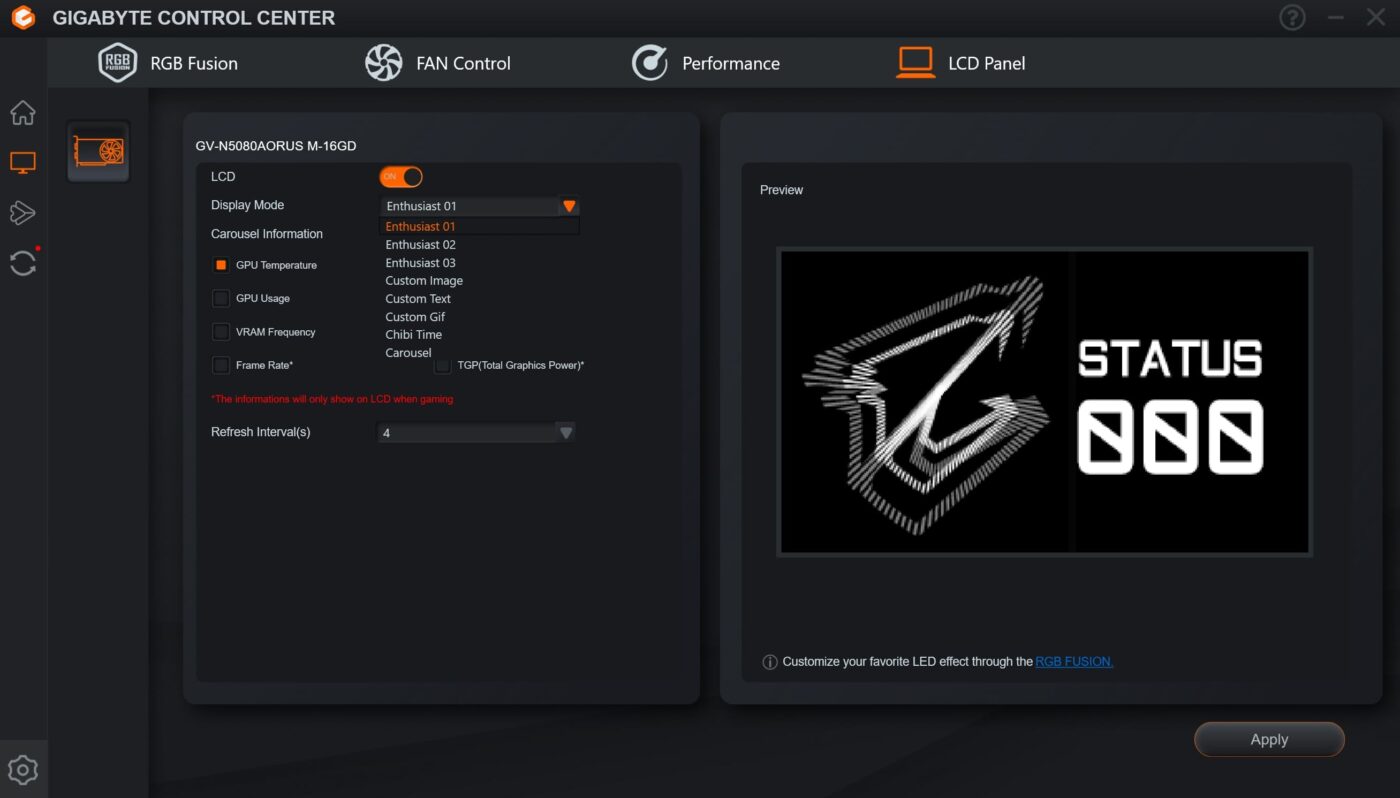

Oprogramowanie producenta, czyli Gigabyte Control Center

Jak zawsze do naszej dyspozycji jest oprogramowanie Gigabyte Control Center, za pomocą którego możemy między innymi zarządzać krzywą wentylatorów, OC karty, RGB czy zarządzać naszą nowością, czyli wyświetlaczem LCD EDGE… I na nim się teraz skupimy.

Co można wyświetlić na ekranie karty? Ano wszystkie potrzebne informacje na temat pracy komputera – od temperatury po taktowanie, na FPS-ach w grach kończąc. Można wybrać np. podgląd tylko jednego elementu, ale i wielu – to od Was zależy co chcecie uzyskać i co chcecie wiedzieć. Maniacy customizacji mogą wyświetlić nawet swój gif czy zdjęcie… nie wiem po co, ale można ;).

Oczywiście zabawa wyświetlaczem daje dużo frajdy, ale nie tylko do zabawy można go wykorzystać. Możemy też zarządzać podświetleniem i jego trybami – ja się robię chyba już stary, bo mnie interesuje już tylko niebieski i najchętniej statycznie (niestety, w akcie urodzenia mam napisanie “Rzeczpospolita Polska Ludowa”).

Wincyj ledóf!!!!

Jak już wcześniej wspominałem, znajdziemy tutaj RGB – i to wcale nie TAK MAŁO. Do dyspozycji i pełnej regulacji mamy cztery punkty świetlne, którymi możemy zarządzać z pozycji oprogramowania (trzy wentylatory plus podświetlane logo producenta z boku karty). Jest to rozwiązanie stare i znane w kartach tego producenta już od ładnych paru generacji.

Jak to działa? Podświetlenie wentylatorów GPU załącza się w momencie, gdy chłodzenie zaczyna działać. Jest to rozwiązanie, hmmm, do którego można się przyzwyczaić, ale nie jest idealne – zasada działania jest taka sama, jak w tych wszystkich azjatycko-bazarowych klamotach, co wyświetlają nam obrazy “3D” poprzez wprawienie ramion z LED-ami w ruch i – gdy osiągają odpowiednią prędkość – cieszą nasze oczy wizualizacjami zaprogramowanych obrazów/filmów (zwał jak zwał). I tu jest ten problem – pełen “okrąg” na karcie ukaże się dopiero, gdy wentylatory osiągną prędkość około 70-75%, co w moim przypadku prawie nigdy nie miało miejsca. W efekcie cieszyłem się festiwalem pasków.

Ile będzie nas to kosztować? Prąd, nie karta

Jak wiecie, wydatki to nie tylko zakup, ale i utrzymanie karty graficznej. Warto zatem wiedzieć, że pobór energii w GeForce RTX 5080 wynosi średnio 360 W.

W 2025 roku cena prądu dla gospodarstw domowych wynosi 0,6212 zł brutto za 1 kWh. Cena ta obowiązuje od 1 stycznia do 30 września 2025 roku. Daje nam to zatem 0,22 zł za godzinę gry (obliczenie dla średniego łącznego kosztu w grupie taryfowej G11, co daje 6,71 złotych za miesiąc czy w końcu 81,63 złotych za rok. Chyba spoko, nie?

FLIR, czyli potraktujmy to termowizją

To już chyba standard, że zawsze poszukuję za pomocą kamery termowizyjnej “hotspotów” czyli miejsc, które najbardziej “grzeją” (nie mylić z pojęciem radiacyjnym). Jeśli przyjrzycie się dokładnie i porównanie zdjęcia wykonane przy tej karcie, a przy innych, to zobaczycie, że ten backplate wydziela ok. kilkanaście stopni więcej… I bardzo dobrze! To tylko oznacza, że zastosowanie ciekłego metalu sprawdza się, gdyż możemy szybciej pozbyć się ciepła z wnętrza naszego GPU!

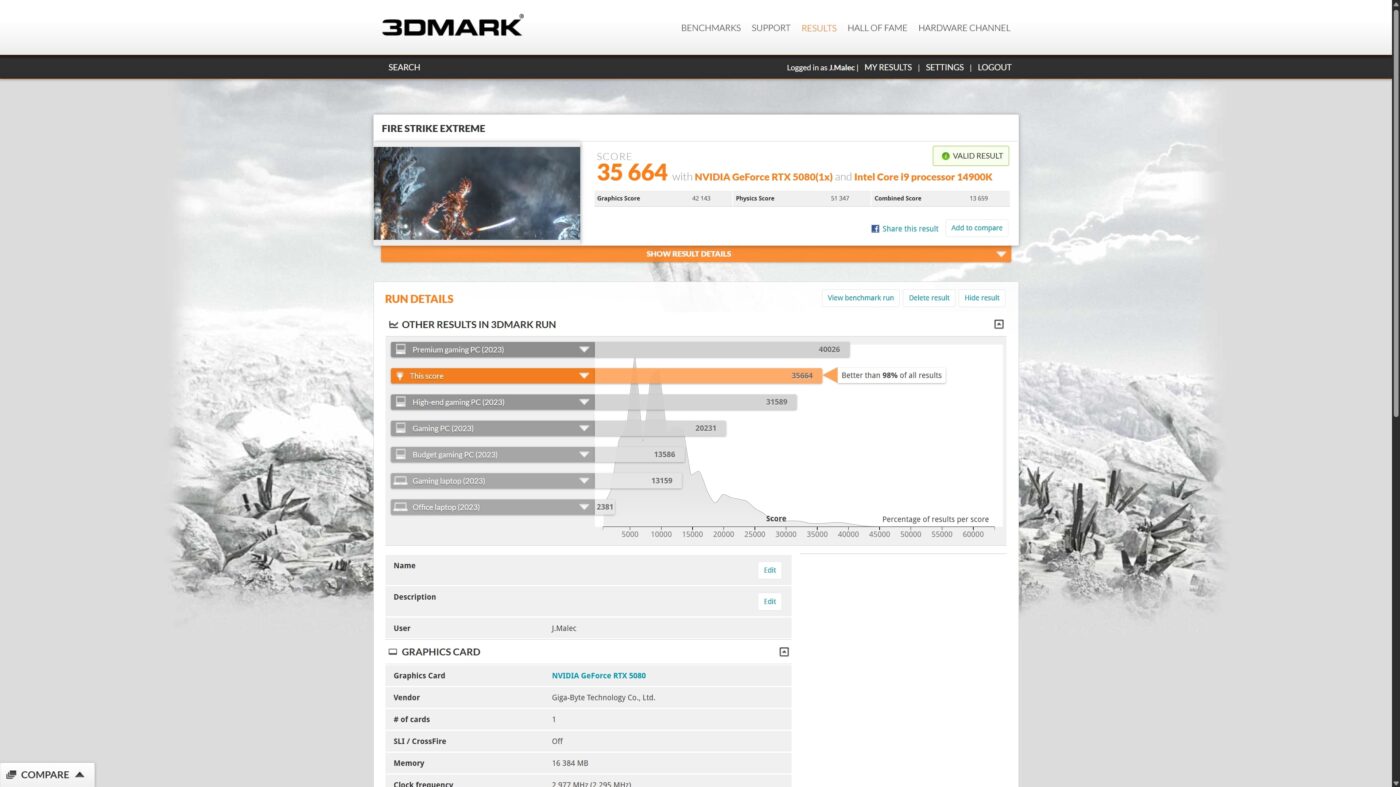

Benchmarki

Przed graniem warto spojrzeć na surową moc. Aż muszę zacytować Walaszka “spoć się dla mnie siłaczu” ;)

3DMark:

- Speed Way: 9244

- Steel Nomad: 8616

- Fire Strike: 46583

- Fire Strike Extreme: 35664

- Fire Strike Ultra: 22229

- Time Spy: 30891

- Time Spy Extreme: 15838

- Port Royal: 22418

- test funkcji NVIDIA DLSS (3840×2160):

- DLSS off – 49.87FPS

- DLSS on – 299.02FPS

- test funkcji DirectX Raytracing (3840×2160): 101.59FPS

- test obciążeniowy “Steel Nomad”:

- stabilność – 98.8% (zdany)

- pętla najlepsza – 8628

- pętla najgorsza – 8522

GRY! (no ile można czekać?!)

Zanim rozpoczniemy kilka słów wstępu. Gry trzeba podzielić na te, wykorzystujące standardową rasteryzację, jak i te, które są wspierane przez DLSS 3.5/4. Oczywiście postaram się, by wszystko w toku ładnie i czytelnie wyjaśnić. Chciałbym jednak, byśmy na wstępie przyjęli, że każdy tytuł był ogrywany w 4K na suwakach w prawo, czyli na maksymalnych ustawieniach, na jakie tylko gra nam pozwalała. Pomijając Escape from Tarkov (ten tytuł to raczej ciekawostka, bo jest tak źle zoptymalizowany, że szkoda mówić… a zatem tylko tutaj gramy w 4K, ale na ustawieniach średnich).

PLAYERUNKNOWN’S BATTLEGROUNDS

Zacznijmy spokojnie, ale wydajnie. Ten tytuł obchodzi już setne urodziny (taki żarcik ;)). Nie grałem w niego od paru lat, a dokładnie od momentu jak przeszedł na Free to Play i zrobili z czegoś fajnego… parodię dla nastolatków. No cóż, jakoś trzeba z tym żyć.

Jako że ten tytuł nie wspiera żadnych technik DLSS, to i tak śmiało mogę powiedzieć, że gra się w niego całkiem przyjemnie (od 185 do 230 FPS uświadczymy).

Sid Meier’s Civilization VII

Mówcie, co chcecie, w ten tytuł gra mi się serio przyjemnie. Jak już zacznę małą partię, to znikam na długie godziny.

Ponownie uświadczymy tylko standardową rasteryzację, ale myślę, że wynik może powodować u nas niemały uśmiech na twarzy.

Uświadczymy tutaj od 140 do 160 FPS.

PAYDAY 3

Lubicie? Gracie? Podobno dwójka lepsza i dalej ma xxx razy więcej aktywnych graczy, ale moim zdaniem trójka wygrywa. A i nie gra się najgorzej – od 135 do 160 FPS w 4K na max detalach może się podobać!

Simrail

Powiem to samo, co rok temu – ten tytuł moim zdaniem ma ogromny potencjał, który – mam nadzieję – nie zostanie zabity! I tutaj mam zagwozdkę, bo nie wiem czy to praca deweloperów, czy moc obliczeniowa karty, ale mamy wyniki o wiele lepsze niż rok temu.

Wtedy gra uzyskiwała od 30 do 80 FPS-ów, a dziś? Okolice 60 do ponad 120! No jestem pod małym wrażeniem! Co ważne, twórcy chcieli w tym tytule zaimplementować DLSS, ale… prawie nic nie daje, więc powiedzmy, że tego w ustawieniach nie widziałem.

Escape from Tarkov

Moja pięta achillesowa, mój gwóźdź w oku! Escape from Tarkov – przegrałem w ten tytuł setki godzin i – tak – dalej mam wrażenie, że jestem na poziomie gdzieś pomiędzy robak a scav… nieważne! Ten tytuł musimy już podzielić.

Standardowa rasteryzacja: od 100 do 120 FPS (zależne od mapy – z dropami do 50)

DLSS: od 100 do 120 FPS (zależne od mapy – z dropami do 50)

Zakończeni? Podobno team zaimplementował DLSS 4… jakoś im nie wierzę! Szczerze, oni jedno mówią, drugie robią – i tak od samego początku istnienia tej gry…

Jednak jest coś, co powoduje, że implementacja DLSS w tym tytule jest prawdopodobna, bo graficznie gra po uruchomieniu w trybie DLSS ”K” (nie pytajcie co to jest – oznaczają różne warstwy za pomocą alfabetu) faktycznie wygląda o wiele ładniej. Może i nie mamy niesamowitego wzrostu wydajności, ale jakość też jest dużym plusem!

Microsoft Flight Simulator 2024

No i mamy pierwszego bohatera symulatorów lotniczych! Po nieudanej premierze i utracie zaufania wieloletnich graczy (sam się do nich zaliczam) powoli zaczynam wracać do tego tytułu. Na cel – jak zwykle – moja ukochana Barcelona.

Standardowa rasteryzacja: od 40 do 55 FPS

DLSS 3.5: od 95 do 120 FPS

Kingdom Come Deliverance II

No w końcu pierwsza gra, która w pełni wykorzystuje DLSS 4! I – nie powiem – jestem zachwycony. FPS-ów może i można by było uzyskać jeszcze więcej (mówię o tym, co zobaczycie zaraz na screenach), jednak ja wolę grać na ustawieniach DLSS Jakość, co nie dość, że poprawia wyświetlany obraz, to… a zobaczcie sami ile zyskałem :)

Standardowa rasteryzacja: od 15 do 70 FPS – TAK! Zdarzały się takie dropy, idealnie udało mi się to przedstawić na załączonym screenie.

DLSS 4: od 90 do 120 FPS – z czego gra była płynna i niesamowicie przyjemna, jakość obrazu też wzrosła (same plusy).

Hogwarts Legacy

To już jest kombajn dla DLSS 4, a – zresztą – zobaczcie sami.

Standardowa rasteryzacja: dd 70 do 80 FPS (bardzo stabilnie)

DLSS 4: od 250 do 330 FPS – robi to efekt wow, niestety, momentami przy zbyt mocnych ruchach widać lekko poszarpany obraz. Dla własnej przyjemności ustawiłbym generowany obraz na x2 nie x4.

I deser!

Cyberpunk 2077

Standardowa rasteryzacja: od 60 do 100 FPS

DLSS 4: od 250 do 350 FPS

No powiem tak… szczęka opada, jak się tego doświadcza na żywo. Robi to show!

Podsumowanie

Moje pytanie na koniec: przyjrzeliście się temperaturom GPU? Jeżeli nie, to wróćcie do screenów z grami i zobaczcie jeszcze raz jak efektywnie ta karta pracuje! Jak dla mnie to bomba!!!

Podsumowując mój test konsumencki – co nam da połączenie Intel Core i9 14. generacji oraz GeForce RTX 5080? Dużo FPS-ów! Ale czy warto? To kolejne pytanie, które mam z tyłu głowy: czy warto inwestować tak chore pieniądze (wróćcie na chwilę na początek tej recenzji i przypomnijcie sobie, ile to GPU kosztuje… ile ogólnie RTX-y 5080 kosztują)?

Jeżeli przyjmiemy, że karty w końcu będą kosztować tyle, za ile były zapowiadane, to – TAK – ta karta jest warta każdej złotówki. Od super bajerów z zewnątrz po najnowsze technologie w środku, na fajnej wydajności kończąc (nie powiem, że świetnej, bo aż takiej różnicy w stosunku do 4080 nie ma) – to najważniejsze jej zalety.

Ale jeżeli karta ma dalej utrzymywać się w aktualnym pułapie cenowym… to już Wasze pieniądze i nie mnie decydować na co je wydacie. Znam jednak kilka innych fajnych rzeczy, na które może taką kwotę wydać (nawet wakacje na Zanzibarze).

Gdybym miał ocenić samą kartę to mocne 9/10… Za wydajność, dodatki czy wykonanie… Ale jeżeli miałbym ją oceniać w tej cenie, to jest 6/10, bo są jakieś granice… A i wadliwa przejściówka nie pomaga – dodaję ten fakt do minusów, ale mam nadzieję, że to był pojedynczy przypadek (jeżeli ktoś z Was ma tą samą kartę – odezwijcie się, jestem ciekaw czy mieliście podobny problem).