Kwantowy komputer w praktyce

Sama idea komputera kwantowego jest genialna i przełomowa. Jak zwykle w takim przypadku, problemy pojawiają się podczas praktycznej realizacji fizycznej takiego urządzenia. Wynika to głównie z niestabilności stanów kwantowych, które mogą być zakłócone przez najdrobniejsze wahania parametrów fizycznych, takich jak pole magnetyczne, temperatura czy ruch.

Nie oznacza to jednak, że od lat 90-tych nic nie udało się osiągnąć w tej dziedzinie. Kubitami są „zwykłe” cząstki elementarne takie jak fotony czy elektrony. Pierwsze praktyczne konstrukcje do kontrolowanych obliczeń kwantowych zaprezentowano już w 1995 roku, kiedy to udało się skonstruować kwantowe bramki, które przetwarzały kubity. Grupa z Instytutu Technologii w Pasadenie posłużyła się do tego atomem cezu, który został pochwycony w optyczną pułapkę pomiędzy lustrami, a rolę kubitów grały fotony o różnej polaryzacji. A co z zastosowaniami praktycznymi i mocą obliczeniową? Na razie skala jest bardzo mała, mimo dużych rozmiarów samych urządzeń, które muszą być ściśle izolowane od zakłóceń świata zewnętrznego. W tej dziedzinie wiele zawdzięczmy koncernowi IBM, który w 2001 roku stworzył 7-kubitowy komputer kwantowy i za pomocą algorytmu Shora dokonał faktoryzacji liczby 15 (na 5 i 3). W 2011 roku inny zespół na czynniki pierwsze rozbił liczbę 21 (7 x 3). Wydać dziesiątki milionów dolarów na obliczenie, które dzieci wykonują w szkole podstawowej? Spokojnie, to dopiero nieśmiałe początki…

https://www.youtube.com/watch?v=jg8iCnQTLfM

Głośno jest też o firmie D-Wave Systems projektującej komputery kwantowe, szczególnie po ogłoszeniu, że niektóre egzemplarze testowe trafiły do Google i NASA. W 2007 roku zaprezentowano układ oparty na 128 kubitach, ale niestety architektura tego komputera jest tajemnicą i nie do końca można zweryfikować zapewnienia twórców i producenta. W roku 2012 użyto 84-kubitowego komputera tej firmy do obliczenia liczb Ramseya (kolejny problem klasy NP) na małą skalę. Maszyny wykorzystywane przez Google i NASA to w teorii jednostki 128-kubitowe, ale para naukowców John Smolin i Graeme Smith (ale nie TEN Lee Smolin) na łamach Nature opublikowali pracę, która kwestionuje pełną kwantowość rozwiązania od D-Wave. Sceptycznie podchodzi do tego też sam IBM. Przedstawiciele D-Wave argumentują jednak, że definicja komputera kwantowego jest szeroka, a ich komputer wykorzystuje prostsze do opanowania zjawiska kwantowego wyżarzania. Na niekorzyść D-Wave zadziałała też publikacja testów algorytmów, które wykazały, że komputer ten nie wykazał żadnej przewagi obliczeniowej nad klasycznymi rozwiązaniami. Komputerami kwantowymi zainteresowana jest też Agencja Bezpieczeństwa Wewnętrznego Stanów Zjednoczonych (NSA). Przyczyny są oczywiste – łamiąc szyfry oparte o faktoryzację dużych liczb, szpiegowanie użytkowników i łamanie zabezpieczeń stałoby się dziecinnie proste.

IBM podchodzi do prognoz bardzo ostrożnie. Zdaje sobie sprawę, że obecna technologia nie jest w stanie pozwolić na tworzenie małych i rozwojowych procesorów kwantowych, a stabilność obecnych rozwiązań pozostawia wiele do życzenia. W tym momencie dochodzimy do bardzo ważnego pytania – który kierunek wybrać? Czy rozwiązania praktyczne z mniejszym potencjałem (jak D-Wave) czy mocno problematyczne rozwiązania teoretyczne, których realizacja umożliwiłaby tworzenie przenośnych i przede wszystkim skalowalnych rozwiązań? Tą drugą drogą od ponad dekady podąża Microsoft. Michael Freedman, matematyk (nagrodzony Medalem Fieldsa – odpowiednik Nobla w matematyce) i fizyk, prawie 15 lat temu został zatrudniony w firmie z Redmond do pracy nad projektem komputera kwantowego. Jednym z jego podstawowych warunków była pełna autonomia działań i otwartość wyników.

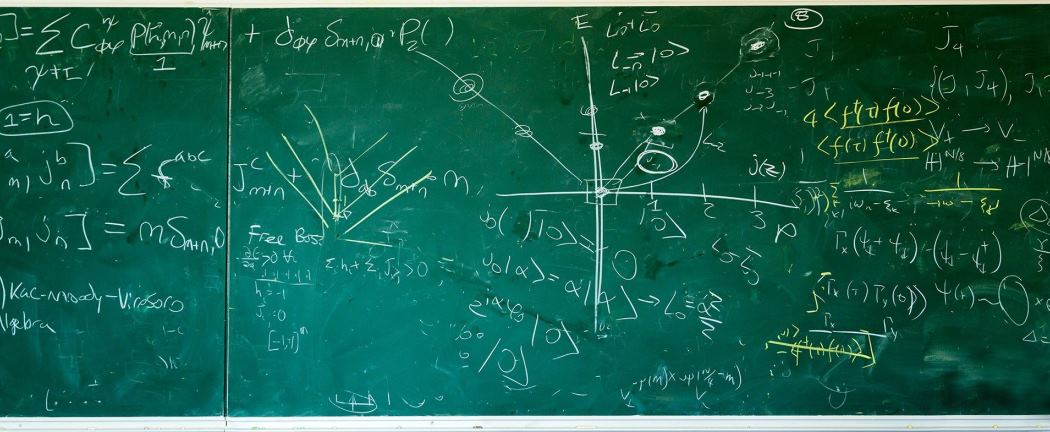

Dzięki temu, w uniwersytecie Santa Barbara w Kalifornii, powstała Stacja Q – oddział badawczy zrzeszający matematyków, fizyków i informatyków, wspólnie pracujących nad teoretycznymi i praktycznymi aspektami projektowania komputerów kwantowych. Pomijając ogromnie skomplikowane szczegóły techniczno-fizyczne, z których zrozumieniem problem ma sam szef Microsoft Research doktor Peter Lee, można powiedzieć, że prace w Station Q zaowocowały odkryciem nowej kwazicząstki (fermion Majorany) i postawieniem na podejście topologicznie (kubity chronione topologicznie oparte na fermionie egzystującym w dwuwymiarowym tunelu złożonym z gazu elektronowego umieszczonego w silnym polu magnetycznym). Mimo tego, że fizyką teoretyczną i kwantową interesuję się od prawie 15 lat, czytając opracowania tego zespołu wielokrotnie traciłem wątek. I nie ma co się dziwić. Niels Bohr, jeden z ojców fizyki kwantowej twierdził, że jeśli ktoś mówi, że rozumie mechanikę kwantową, to… nie rozumie fizyki kwantowej. Ja nie rozumiem.

Co zatem wynika z tego dla nas, zwykłych śmiertelników, nie będących laureatami nagród Nobla czy Fieldsa? Mówiąc najogólniej, chodzi o stabilność, skalowalność i małe rozmiary. Cały zespół podkreśla, że nie ma pojęcia dokąd zaprowadzą ich te badania i czy uda się na ich podstawie zrobić działający komputer kwantowy z praktycznymi zastosowaniami. Jeśli to by się udało, możemy mieć do czynienia z końcem tranzystorowo-silikonowej ery cyfrowej, a implikacje płynące ze zwiększonych możliwości obliczeniowej mogą zmienić nasze życie w wielu dziedzinach. Od szyfrowania, bezpieczeństwa danych, do sekwencjonowania DNA, zwrotów w dziedzinie inżynierii materiałowej czy nowych leków na nieuleczalne choroby. Czy przełom taki jest możliwy i czy urzeczywistni się jeszcze za naszego życia? Pytania te wciąż pozostają otwarte.

Źródła: 1, 2, 3, 4, 5, 6, 7, 8, 9,10, 11, 12, 13, 14, 15, 16, 17, 18

Zdjęcie tytułowe: Microsoft