Jesteśmy świeżo po premierze najnowszych urządzeń Samsunga z serii Galaxy S. Tym razem serwis DxOMark nie czekał kilku lub nawet kilkunastu miesięcy z publikacją oceny możliwości optycznych nowych urządzeń. Ta pojawiła się już dzień po premierze, 21 lutego tego roku, i, ku zaskoczeniu wielu osób, najnowszy Samsung z serii Galaxy nie przebił muru 109 punktów, jakie uzyskały ubiegłoroczne flagowe urządzenia Huawei. Smartfon otrzymał również identyczny wynik 114 punktów w kategorii Photo. Czy oznacza to, że w fotografii mobilnej mamy kompletny zastój i kolejnym urządzeniom będzie coraz trudniej uzyskać wyższe wartości punktowe czy też winę za taki stan rzeczy ponosi sama metodyka serwisu DxOMark?

Premiera Samsunga Galaxy S10+ i opublikowane oceny możliwości optyki tego telefonu skłoniły mnie do postawienia pytania: jak w ogóle ocenia DxOMark, w sensie: skąd biorą się punktacje końcowe (wynikowe) tego serwisu? Jaką stosuje on metodę przyznawania punktacji? Nigdzie w sieci nie znalazłem odpowiedzi na tak postawione pytania. Przyjrzyjmy się więc po kolei poszczególnym zagadnieniom w tym zakresie.

Kolejność na liście urządzeń

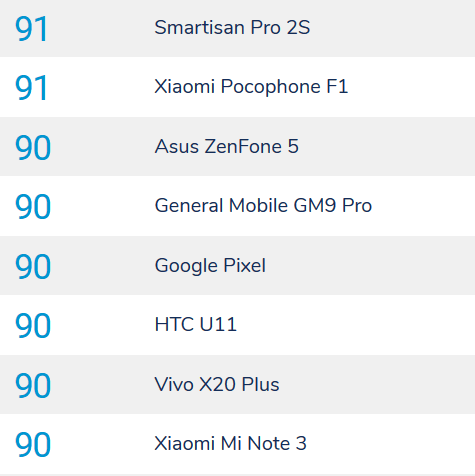

Wydaje się oczywiste, że smartfony z wyższą punktacją zajmują wyższe miejsce w zestawieniu ogólnym niż te z niższą. A co się dzieje w sytuacji, gdy kilka urządzeń otrzyma identyczną notę? Czy brane są pod uwagę składowe foto i wideo? Nie. W takiej sytuacji serwis po prostu szereguje urządzenia wg kolejności alfabetycznej. Widać to najlepiej przy punktacji 90, gdzie uszeregowano kolejne smartfony od Asusa do Xiaomi:

Stąd też pierwsze miejsce w zestawieniu utrzymuje Huawei Mate 20 Pro. Nie dlatego, że uzyskał np. więcej punktów składowych w jakiejś kategorii, ale dlatego, że tak po prostu wynika z… kolejności alfabetycznej. Gdybyśmy jednak chcieli uszeregować pierwsze trzy telefony w sposób bardziej miarodajny okaże się, że np. Huawei P20 Pro ma wyższe noty za wideo od Mate 20 Pro i Samsunga Galaxy S10 i to on powinien być traktowany jako lider zestawienia z punktacją 109,1 punktu:

| model | Huawei Mate 20 Pro | Huawei P20 Pro | Samsung Galaxy S10 Plus |

| PHOTO | 114 | 114 | 114 |

| VIDEO | 97 | 98 | 97 |

| MOBILE | 109 | 109 | 109 |

Jeżeli jednak interesuje nas wyłącznie ocena fotograficzna, to rzecz robi się bardziej skomplikowana:

| model | Huawei Mate 20 Pro | Huawei P20 Pro | Samsung Galaxy S10 Plus |

| JAKOŚĆ OGÓLNA | 596 | 590 | 598 |

| BOKEH + ZOOM | 130 | 143 | 133 |

| SUMA PKT | 726 | 733 | 731 |

| OCENA PHOTO | 114 | 114 | 114 |

Mimo identycznej oceny ogólnej 114 pkt to Huawei P20 Pro prowadzi w ogólnej sumie uzyskanych punktów za poszczególne składowe (733 vs 726 Mate 20 Pro), ale prowadzi tylko i wyłącznie dlatego, że uzyskał znacznie wyższą punktację za dodatkowe parametry Bokeh i Zoom, wprowadzone w 2017 roku. Gdybyśmy oceniali wg starych zasad, wygrałby… Samsung Galaxy S10+ z przewagą 8 pkt nad P20 Pro. Widzimy więc wyraźnie, że dobór kategorii ocen może zaburzyć wynik końcowy, a suma ogólna powinna być uszczegółowiona przynajmniej do jednego miejsca po przecinku

Ocena końcowa Mobile

No właśnie, skąd się bierze ocena końcowa „Mobile”? Z prostej średniej ocen foto i wideo? Nie. Szybka analiza kilkudziesięciu pierwszych smartfonów pozwoliła mi stwierdzić, że znacznie większy wpływ (większą wagę) ma składowa Photo a serwis do wyznaczenia oceny końcowej Mobile stosuje dwie, proste wagi:

2/3 oceny za Photo + 1/3 oceny za Video = ocena końcowa Mobile

Schemat ten zgadza się praktycznie w każdym przypadku z wyjątkiem dwóch sytuacji: Samsung Galaxy S9 Plus powinien otrzymać 100 pkt a nie 99, Galaxy Note 8 powinien dostać 95 punktów a nie 94. Zasady arytmetyki są proste. Jeżeli znamy stosowany schemat, mówimy: sprawdzam i okazuje się wtedy, że DxOMark albo z premedytacją zaniżył ocenę dwóch flagowców Samsunga z 2018 roku o 1 pkt, albo też stosowane równanie jest jednak znacznie bardziej skomplikowane i nie nam, śmiertelnikom, je oceniać. Osobiście stawiam jednak na proste rozwiązania. Jeżeli schemat pasuje do wszystkich urządzeń z wyjątkiem dwóch to coś jest nie tak. Prawdopodobnie jednak winę za taki stan rzeczy ponosi subiektywny sposób zaokrąglania. 108,33 zaokrąglimy sobie do 109 pkt, żeby Mate’owi 20 Pro nie było smutno, że przegrał jednym punktem z P20 Pro, a Samsung Galaxy S9 z wynikiem 99,66 zrównamy w dół do 99, bo tak. W każdym razie, jeżeli zastanawiacie się, skąd wzięła się ocena ogólna Mobile, w 99% przypadków wystarczy wziąć 2/3 oceny za Photo i dodać 1/3 oceny za Video, by otrzymać wynik końcowy.

Ocena składowa Photo

Przejdźmy jednak na wyższy poziom abstrakcji. Skąd biorą się oceny wynikowe za jakość optyczną aparatu głównego (tylnej kamery)? W jaki sposób są wyznaczane? Tutaj nie udało mi się odkryć prostego schematu, ale jedynie ogólny, stosowany zamysł wymagający dokładnego wyliczenia wag.

Do 2017 roku sprawa była prosta. Serwis oceniał siedem składowych, od Ekspozycji po Flasz, przyznawał punkty w skali od 1 do 100 i wyliczał średnią, czyli dzielił sumę przez 7. Przykład:

| model | Samsung Galaxy S8 | LG G5 | LG G6 |

| SUMA PKT | 613 | 613 | 594 |

| ŚREDNIA | 87,6 | 87,6 | 84,9 |

| OCENA PHOTO | 88 | 88 | 85 |

Tutaj też zdarzają się jednopunktowe wyjątki i raczej mają one charakter po raz kolejny wynikający z zaokrąglania wartości po przecinku.

Pod koniec 2017 roku sytuacja się skomplikowała. Dodano dwie nowe składowe: Bokeh oraz Zoom a wartości uległy nagłej zmianie. Od tej pory oceny za Tekstury, Szumy i Artefakty spadły o kilkadziesiąt punktów i wydaje się, że w tych trzech kategoriach maksymalna liczba pkt wynosi 80 a nie 100. Dla przykładu Galaxy S10 Plus za Tekstury otrzymał 70 pkt, S9 Plus 67 pkt, a S8 wg starszej oceny… aż 92 punkty. Czy oznacza to, że S8 wykonuje bardziej szczegółowe zdjęcia? Nie. Oznacza to wyłącznie zmianę sposobu przyznawania punktów w tych trzech kategoriach, o której nie informowano publicznie. Stąd też nierzetelne są twierdzenia, że LG G7 ThinQ wykonuje „wg DxOMark” gorsze zdjęcia od starszych modeli LG G6 i LG G5 z prostego powodu: smartfony te były ocenianie wg innych zasad i idąc tym tokiem rozumowania należałoby stwierdzić, że LG G5 (z sumą pkt 613 za 7 kategorii) robi lepsze zdjęcia nie tylko od LG G7 ThinQ ale… od wszystkich innych smartfonów po 2017 roku, co jest oczywistą nieprawdą.

Przejdźmy jednak do meritum i próby sprawdzenia szacowania przez DxOMark oceny możliwości fotograficznych. Jak pewnie zauważyliście, punktacja w tym zakresie od dłuższego czasu przekracza 100 punktów, a pierwsze trzynaście modeli na liście otrzymało od 103 do 114 pkt w kategorii Photo. Pierwsza myśl, jaka przyszła mi do głowy, była następująca: skoro do 2017 roku wyciągano prostą średnią z 7 głównych kategorii, to po zmianie zasad oceny do tej średniej dodaje się dodatkowe punkty premiowe za Bokeh i Zoom. I faktycznie, wszystko na to wskazuje. Jeżeli odejmiemy od oceny końcowej Photo średnią punktów za pierwsze 7 kategorii, to otrzymana premia punktowa wynosi ok. 0,21 – 0,23 dwóch dodatkowych kategorii. I takie uogólnienie nawet by wystarczyło. W praktyce okazuje się jednak, że ocena za Zoom ma większy wpływ niż druga składowa za Bokeh, a zmiana Zoomu o 3 pkt podnosi ocenę o 1 pkt. To doprowadziło mnie do następującego wniosków:

1/7 ocen z 7 kategorii głównych + 1/3 oceny za Zoom + 1/9 oceny za Bokeh = ocena końcowa Photo

Spójrzmy na kilka przykładów:

| model | Mate 20 Pro | HTC U12+ | Pixel 3 | LG G7 ThinQ | LG V30 |

| waga 7 x 1/7 | 85,1 | 83,1 | 81,6 | 71,9 | 72,9 |

| waga 1 x 1/3 | 22,4 | 16,0 | 15 | 8 | 11,2 |

| waga 1 x 1/9 | 6,6 | 5,5 | 5,5 | 4,4 | 2,8 |

| Suma zaokr. | 114 | 105 | 102 | 84 | 87 |

| Ocena DxO | 114 | 106 | 103 | 84 | 87 |

Jest to pewien schemat przybliżony, więc oczywiste jest, że dla modelu X lub Y ocena może być o 2 pkt inna niż powinna. Ma on oddawać ogólny sposób przeliczania ocen składowych na wynik końcowy Photo, a poszczególne wagi mogą być (i na pewno są) odrobinę inne. Szczególnie że Ekspozycja, Kolor i Autofokus wydają się mieć o jakieś 10% większe znaczenie, niż niżej obecnie oceniane Tekstury, Szum i Artefakty. Pomijam przy tym sensowność doboru tych kategorii (trzy składowe dotyczące szczegółowości + autofokus, czyli ocena za mechanikę działania obiektywu i szybkość oprogramowania), bo to tak, jakby przyznawać punkty w kategoriach: Sierść kota, Uśmiech kota, Pazury kota i Szybkość machania łapą). Halo. Wolałbym poza tym bardziej życiowe kategorie, np. jakość zdjęć dziennych, jakość zdjęć nocnych, jakość zdjęć portretowych, jakość zoomu / teleobiektywu, jakość szerokiego kąta i bez sumowania, bo suma ogólna nie mówi nam nic, jak wyżej przytoczony kot wygląda w dzień, a jak w nocy. Znamy tylko parametry jakościowe jego sierści, ale z oceny tej nie dowiemy się, jakie są składowe dzienne i nocne tej oceny. A chyba bardziej by nas interesowało jak dany aparat radzi sobie w nocy, niż jakie generuje artefakty, bo te mogą być różne w zależności np. od wybranej rozdzielczości zdjęcia i np. w trybie 40 Mpx Huaweia P20 Pro są nie do przyjęcia.

Wnioski

W każdym razie, jedno mogę napisać z całą odpowiedzialnością: metodyka oceny serwisu DxOMark jest wadliwa, ponieważ serwis zamiast wyciągać średnią ogólną z ocen, przyznaje punkty premiowe za Bokeh i Zoom, a waga kategorii Zoom jest znacznie wyższa od innych, przez co wszystkie smartfony z teleobiektywami mają zagwarantowany bonus na start do oceny. Jeżeli do tej pory wydawało nam się, że sposób wyliczania punktacji końcowej DxOMark jest nie do końca właściwy, to teraz widzimy to czarno na białym: smartfony wspierające optyczny zoom są premiowane wyższymi wagami kategorii Zoom. Dlatego jeśli ktoś chce wyciągać jakieś bardziej sensowne wniosku co do możliwości optycznych, powinien pomijać dwie końcowe składowe oceny, jak również pomijać punkty za ocenę Video. I wtedy otrzymamy dosyć podobną, ale nieco inną kolejność na liście:

| miejsce | DxOMark | ilość pkt Photo | model |

| 1. | 3. | 598 | Samsung Galaxy S10+ |

| 2. | 1. | 596 | Huawei Mate 20 Pro |

| 3. | 2. | 590 | Huawei P20 Pro |

| 4. | 4. | 588 | Xiaomi Mi 9 |

| 4. | 8. | 588 | Xiaomi Mi Mix 3 |

| 6. | 10. | 584 | iPhone XR |

| 7. | 6. | 582 | HTC U12+ |

| 8. | 5. | 579 | iPhone XS Max |

| 9. | 13. | 575 | Xiaomi Mi 8 |

| 10. | 15. | 573 | OnePlus 6T |

| 11. | 11. | 571 | Google Pixel 3 |

| 12. | 9. | 570 | Huawei P20 |

| 13. | 7. | 569 | Samsung Galaxy Note 9 |

| 14. | 14. | 563 | Google Pixel 2 |

| 15. | 12. | 556 | Samsung Galaxy S9+ |

Powyższy przykład pokazuje, że prosta zmiana wagi czy też zmiana kategorii oceny i usunięcie Zoomu powoduje przemieszanie kolejności smartfonów na liście. Należy w tym miejscu zaznaczyć, że poszczególne różnice są na tyle niewielkie, że kolejność ta o niczym nie świadczy, a dwa wynika tylko i wyłącznie z przyjętych kategorii oceny. Gdybyśmy oceniali dodatkowo jakość oprogramowania i trybu manualnego, w tym wideo czy też jakość zdjęć w trybie ultraszerokokątnym, to znacznie wyżej na naszym zestawieniu zawitałyby urządzenia LG (V30, G7 ThinQ, V40 ThinQ). A właśnie. Czy w zestawieniach DxOMark znajdziecie ocenę topowego modelu LG V40 ThinQ, urządzeń Sony czy też sztandarowego modelu foto Microsoftu z 2015 roku Lumii 950XL? No właśnie. W zasadzie dopiero teraz zauważyłem, że na listach brakuje…. Sony. Poza jednym starym modelem XZ. Być może gdyby oceniano wszystkie telefony, a nie tylko wybrane, podium wyglądałoby inaczej.

Podsumowując:

- ocena końcowa poszczególnych smartfonów to w 2/3 ocena Photo, w 1/3 ocena Video,

- przy identycznej punktacji serwis stosuje kolejność alfabetyczną,

- oceny dokonane przed zmianą sposobu oceny są niewspółmierne do nowych ocen z uwagi na inną skalę punktową dla szumów, tekstur i artefaktów,

- ocena składowa Photo premiuje telefony z teleobiektywem, zawyżając wagę dla kategorii Zoom,

- kategorie składowe oceny są subiektywne i nie pozwalają wyciągnąć wniosków np. co do jakości zdjęć dziennych czy też nocnych,

- rzeczą znamienną jest brak ocen niektórych marek i niektórych modeli telefonów (LG V40 ThinQ, flagowce Sony).

Mam nadzieję, że powyższy artykuł rozjaśnił nieco meandry ocen wystawianych w serwisie DxOMark.

Wszystkie wyliczenia mają charakter własny. Źródło bazowe: DxOMark

PS Poprzednią część artykułu znajdziecie w tym miejscu.