Choć Pixel 2 i Pixel 2 XL nie są oficjalnie dostępne w Polsce, na pewno znajdą się tacy, którzy zechcą na własnej skórze przekonać się, czy smartfon od Google’a to dobro najwyższej próby, czy też nie. Zachęcić ich może do tego wiadomość, że firma nie powiedziała jeszcze wszystkiego w temacie jakości zdjęć robionych przez aparaty tych urządzeń. W Pixelach zaszyty jest bowiem dodatkowy procesor obrazu…

Pixel Visual Core – tak nazywa się komponent, którego dotąd Google nie uruchomiło w nowych Pixelach. Mało tego: nie było o nim żadnej wzmianki podczas konferencji, na której je zaprezentowano. Chip ten został zaprojektowany przez Google w celu zwiększenia możliwości aparatu. Układ nie jest aktywny, ale producent mówi, kiedy zamierza go zdalnie uruchomić – podczas aktualizacji Pixela 2 i Pixela 2 XL do Androida Oreo 8.1.

Oczywiście na samym początku nowe możliwości pojawią się przed deweloperami – to oni w pierwszej kolejności zostaną pobłogosławieni przywilejem pobrania nowej wersji systemu Google. Będą mogli wykorzystać Pixel Visual Core do tworzenia aplikacji przetwarzających zdjęcia HDR+. W ten sposób w sklepie Google Play pojawią się apki, które zrobią zdjęcia równie dobre, jak podstawowa aplikacja aparatu w Pixelach.

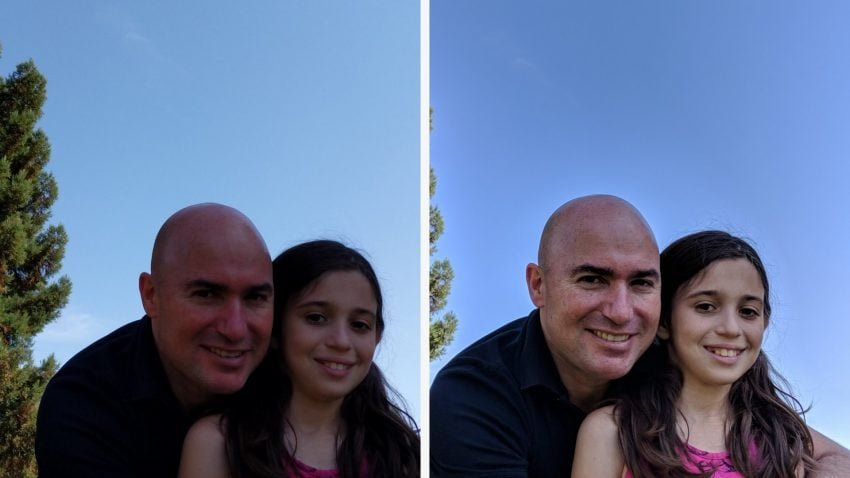

Spójrzcie, jak sprawdza się ten bajer w praktyce. Po lewej: zdjęcia wykonane Pixelem 2 przy pomocy nieoficjalnej aplikacji, a po prawej: zdjęcia z HDR+ wykonane przy wsparciu Pixel Visual Core.

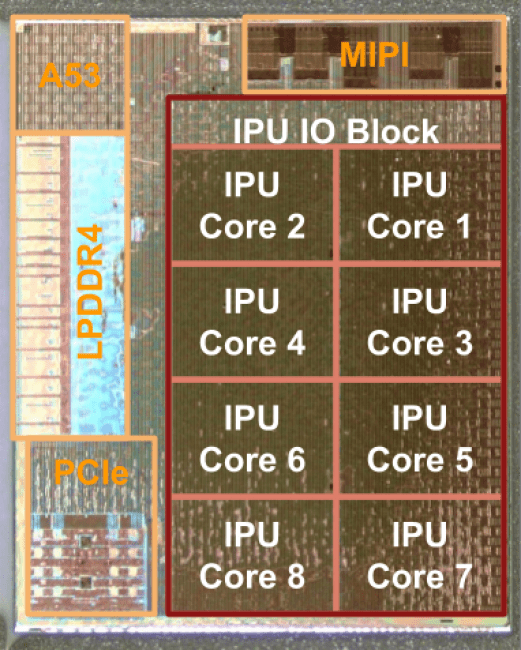

Pixel Visual Core dysponuje ośmiordzeniowym procesorem przetwarzania obrazu (IPU), który radzi sobie z trylionem operacji na sekundę. Według zapewnień Google, rdzenie układu mogą przetwarzać obrazy HDR+ 5 razy szybciej niż dotychczas robi to Pixel 2, jednocześnie ograniczając zużycie energii dziesięciokrotnie.

Mało tego: ten procesor obrazu jest wyposażony we własną jednostkę centralną w postaci pojedynczego rdzenia CPU (w tej roli Cortex-A53) oraz własną pamięć RAM DDR4. Pierwszą aplikacją, która wykorzysta potencjał tego ukrytego potworka będzie „HDR+”, napisana przez deweloperów Google’a. Później pojawią się również inne programy, wiążące Pixel Visual Core z algorytmami uczenia maszynowego.

Wersja deweloperska Androida Oreo 8.1 powinna trafić do programistów w ciągu kilku tygodni. Wtedy też Google „uwolni” Pixel Visual Core z klatki. Ciekaw jestem efektów.

źródło: Google przez Gadgets360