Jeszcze do całkiem niedawna, architektura 64-bitowa była kojarzona jedynie z typowymi komputerami na/pod naszymi biurkami. Jej popularyzacja, jak jeszcze pamiętam, nie spowodowała znaczącej rewolucji, nikt jakoś szczególnie nie przywiązywał do tego uwagi. Dodatkowo, pamiętam, że po zakupie nowego (wówczas) komputera z Phenomem 9500 zdecydowałem się na Windows XP x64, który wysypał się tuż po instalacji. Dopiero Vista oraz 7-ka była w miarę używalna na moim sprzęcie. Z tego też powodu do x64 podchodziłem bez entuzjazmu. Jest, bo jest.

O zmianie architektury na pecetach dawno już zapomniałem, aż tu Apple ni z tego, ni z owego zaskoczyło mnie procesorem A7 wykonanym właśnie w tej architekturze. Zastanawiałem się: „po co?” – i to dosyć długo. Nie było logicznych przesłanek, w świetle których Apple byłoby „usprawiedliwione” w swoim działaniu. Ani 5S nie przekroczył magicznej bariery 4GB RAM, ani nie chodzi tutaj o poprawę wydajności. O co zatem? Wszyscy trąbią o chwycie marketingowym i ja też się przyłączę. Dotąd uważałem, że to rzut kamieniem w stronę Samsunga oraz reszty „bardziej postępowego, niż Apple” rynku opierającym się na cyferkach – czy to w kwestii RAM-u, czy to w rdzeniach i gigahercach. Tak oto uważałem, że Samsung kolejnym flagowcem zaatakuje dzisiaj jeszcze bardzo wąską niszę mobilnych urządzeń opartych o architekturę 64-bitową.

I w tym przypadku się myliłem, bowiem Samsung zdecydował się tylko na face lifting swoich flagowych urządzeń, nie przekroczył magicznej bariery pamięci operacyjnej i dodał jedynie kilka funkcji do swojego sprzętu.

Apple to wszystko argumentowało potrzebnym skokiem wydajności w stosunku do poprzedników. Mawiano także o tym, że urządzenia takie jak iPhone, czy iPad to sprzęt dla profesjonalistów, którzy oczekują odrobinę więcej od tabletu, czy smartfona i wejście w architekturę 64-bitową będzie wstępem do zmian na tym polu. To dla mnie było odrobinę dziwne, bo wiem, że przejście na wyższą architekturę wcale nie musi powodować przytaczanych przez Apple korzyści. Ba, jestem pewien, że konsumenci nie odczują żadnej zauważalnej różnicy. Bo raz, że na takim urządzeniu rzadko kto rozpakowuje skompresowane pliki, czy koduje filmy, a dwa, że 5S posiada w zanadrzu tylko 1 GB pamięci RAM. Drodzy Państwo, widzicie jakąkolwiek różnicę między iPhone 4S, 5, 5C, 5S, jeśli chodzi o wydajność? Miałem w rękach wszystkie te urządzenia i właściwie, to one działają podobnie szybko. Słowo klucz: „szybko”, dodałbym, że „wystarczająco szybko”.

W założeniach, 64 bity wyglądają na papierku dużo lepiej od 32

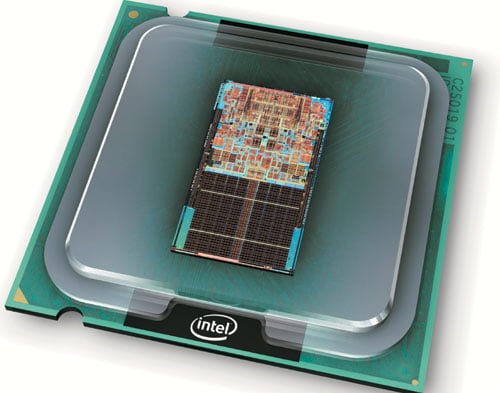

Architektura jest modelem przetwarzania danych o rozmiarze 64 bitów przez procesor. Jak chodzi o pamięć, to do zaadresowania jest aż 16 eksabajtów danych, natomiast w 32 bitach zaadresujemy tylko 4 GB. Tym samym taka ilość pamięci zdatnej do zaadresowania wystarczy nam na długi czas. Tym samym otrzymujemy model przetwarzania danych, który z założenia gwarantuje nam wyższą wydajność, zwiększoną przestrzeń pamięci adresowej, czy też wyższą precyzję wykonywanych obliczeń przez procesor. Na 64-bitach będziemy w stanie także uruchomić aplikacje napisane na starszą architekturę dzięki mechanizmom zawartym w systemie operacyjnym – w systemach z rodziny Windows jest to WOW64 (WindowsOnWindows64). Nowa architektura to nie tylko zalety, ale również poważne, z punktu widzenia i systemu i deweloperów, wady. Po pierwsze, w wypadku 64 bitów zapotrzebowanie na pamięć jest nieco większe, a przejście na nową architekturę wywołuje potrzebę optymalizacji kodu dostępnych aplikacji. W przypadku iOS upłynie jeszcze wiele wody w Wiśle, zanim będzie można powiedzieć, że takich programów jest dużo. Przepisanie aplikacji to proces drogi i czasochłonny. I wydaje mi się, że w wielu przypadkach także jest on niewarty tego, by zaprzątać sobie nim głowę. Co innego, jeśli mówimy o naprawdę zaawansowanych aplikacjach, w których zastosowanie nowej architektury byłoby rozsądnym rozwiązaniem.

Jakoś ciężko jest mi wyobrazić sobie kodowanie filmów, czy rozpakowywanie dużych, skompresowanych plików na tabletach. Chyba, że…

Popatrzymy mocno w przyszłość?

Patrząc na przykład na urządzenia mobilne z Ubuntu na pokładzie, czy z Androidem – w ramach których korzystanie z zewnętrznych sprzętów wskazujących jest możliwe, nie można oprzeć się wrażeniu, że takie rozwiązanie może mieć sens.

Urządzenia z Windows 8.1 na pokładzie korzystają głównie z architektury 64-bitowej. Właściwie w całym spektrum dostępnych modeli można je podłączyć do zewnętrznego sprzętu pozwalającego na wyświetlanie obrazu, czy też używać ich za pomocą klawiatury oraz myszki. Po tym krótkim wstępie nowego akapitu już pewnie wiecie, do czego piję, prawda?

Architektura 64-bitowa ma zastosowanie w profesjonalnych rozwiązaniach. Jej walory docenią graficy, osoby pracujące nad obróbką wideo, programiści. Wszędzie tam, gdzie sprawdzi się większa przestrzeń adresowa i gdzie liczy się ilość pamięci RAM, 64-bity będą logicznym i zrozumiałym rozwiązaniem. W każdym innym przypadku – uważam to za przerost formy nad treścią. Po co komu wyższa architektura, skoro korzyści z niej mieszczą się w granicach błędu statystycznego?

I tak oto niedawno w sieci pojawiła się informacja, że Nexus 8 będzie pracować na tej właśnie architekturze, w ramach korzystania z dobrodziejstw procesora Intel Atom Bay Trail. I o ile ten procesor pozwoli na uzyskanie świetnej wydajności, to już jego architektura wskazuje, że Google szykuje się na coś naprawdę mocnego. Czy pojawi się tam więcej, niż 4 GB RAM (albo chociaż to 4 GB)? Zobaczymy – ale właściwie nic nie stoi temu na przeszkodzie. Ostatnie urządzenia Samsunga pojawiły się w konfiguracji z trzema gigabajtami, może Nexus podniesie poprzeczkę i tym samym zmusi innych producentów na przesiadkę na wyższą architekturę.

Do czego taki tablet może nam służyć? Cóż, gdybym posiadał tablet z Windows 8.1 pracujący na przynajmniej Core i5, przyzwoitej grafice i dużej ilości pamięci RAM, to zapewne mógłbym go użyć do bardziej profesjonalnych zastosowań. Bay Trail też zły nie jest, ale to zupełnie nie ta klasa urządzeń i myślę, że w przypadku Bay-Trail pewne wydajnościowe kompromisy dawałoby się odczuć.

To producenci wyznaczają kierunek rozwoju urządzeń, choćby był on absurdalny

Te 64 bity w urządzeniach mobilnych mają swoje zalety. Ale są one strasznie mgliste. I o ile w tabletach będzie to mieć jakiś sens (o ile będzie się dało je wykorzystać, tutaj już odbijam piłeczkę w stronę deweloperów aplikacji – czy to na iOS, czy na Androida), to w smartfonach… cóż. Nie porysujemy na nich w AutoCAD, obrabiać obrazu też nie. No, chyba, że będzie się dało ich używać, jak dotychczas komputery.

Jednak to, co obserwujemy jest w pewnym sensie nieuniknione. Prawo Moore’a zakłada, że w ciągu dwóch lat, osiągi naszych urządzeń będą się podwajać. Ale gdzieś jest granica. Tą granicą była architektura i zaczynamy ją powoli przekraczać. Bo kiedy stajemy przed granicą możliwości urządzeń, nie ma się już na co bić. A walka na specyfikacje dalej trwa w najlepsze. Najpierw megaherce, potem gigaherce, następnie rdzenie, a razem z nimi ilość pamięci RAM. Tuż za tymi wartościami były ekrany, wersje Androida, sloty na karty pamięci, pamięć flash. Rynek ostatnio lekko ostygł pod tym względem i bardziej przywiązano uwagę do usług. Microsoft ochrzcił Nokię X swoimi usługami tworząc (brzydko to ujmę): „Taniego bękarta z misją przemycenia usług Microsoftu do świata Androida”. Już pomijam fakt, że wszystkie znaki na niebie i ziemi wskazują na to, że będzie się on sprzedawał bardzo dobrze.

A teraz wygodnie rozsiądźmy się w fotelach i cierpliwie czekajmy na kolejne urządzenia w nowej architekturze.