Może i spędzamy w internecie coraz więcej czasu. Może siedzimy w nim po kilka godzin dziennie. Może i częściej rozmawiamy z ludźmi w internecie niż w realu. Ale i tak internet zamieszkują dziś roboty, a nie ludzie.

Obecnie wpiętych jest do sieci około 12,5 miliarda urządzeń. Komputerów, routerów, drukarek. Również tabletów i smartfonów (to “wpiętych” nie było zbyt szczęśliwie wybrane). Użytkowników smartfonów jest już 1,75 miliarda. Jak na ogólną liczbę ludzi na świecie (ok. 7 miliardów) to moim zdaniem całkiem sporo. Wraz z innymi użytkownikami daje to łącznie 2,9 miliarda ludzi, którzy używają internetu. Prawie 3 miliardy użytkowników! Ponad 1 / 3 wszystkich mieszkańców świata. Jakieś 70 proc. z nich korzysta z internetu codziennie. Co sekundę ląduje w necie 8 ludzi.

Wielu z nich robi to, by znaleźć jakąś informację. Google notuje dziennie ponad 3 miliardy wyszukań w swej wyszukiwarce. Rocznie daje to wielkość rzędu 2 bilionów wyszukań.

Ale w internecie ludzie nie tylko wyszukują, ale też tworzą. W maju 2013 roku do Youtube co minutę wpadało 100 godzin nowych filmów wideo, do Soundclouda 11 godzin muzyki. Szacuje się, że w 2014 roku stworzymy lub podzielimy się około 6 zetabitami informacji. To około 824.633.720.832 gigabajtów notek, wpisów, filmików, komentarzy, zdjęć, interakcji, lajków. W br. przekroczymy prawdopodobnie liczbę miliarda serwisów internetowych. Codziennie powstaje ich 140 tysięcy. Samych zwykłych stron internetowych w 2013 roku było już prawie 14,5 tryliona.

Codziennie piszemy 180 milionów twittów. Klikamy prawie 3 miliardy lajków. Wysyłamy od 140 do 190 miliardów maili (różne dane znalazłem). Z czego 70 proc. to spam. Ha.

To wszystko daje dziś około 52 petabajtów ruchu w internecie miesięcznie. Czyli tak pi razy oko 54.525.952 gigabajta danych.

A ludzie robią z tego niecałe 40 proc.

Czy wiesz, że przed Tobą ten tekst przeczytały już co najmniej dwa boty?

Co robią “dobre roboty”?

Boty to na przykład narzędzia skanujące wyszukiwarek internetowych. Jeśli publikujemy treści w internecie i chcemy, by były dostępne z poziomu np. Google, to oczywiście kibicujemy im jak najbardziej i liczymy, że odwiedzą nas jak najprędzej. Bywa, że nowa strona indeksuje się już po kilku minutach. W dużych serwisach dzieje się to nawet po kilku sekundach. Są oczywiście sposoby, by to przyspieszyć. Ale nawet, jeśli po prostu postawimy sobie stronę w sieci bez żadnego udostępniania linków do niej, to w ciągu kilku godzin, maks dnia, znajdzie się w wyszukiwarce. Przypomnę, że stron na świecie jest prawie 15 trylionów. Nie potrafię sobie wyobrazić, jak wiele robotów Google, Binga, Yahoo i innych usług wyszukiwania krąży po internecie i sprawdza, co tam u mnie nowego…

Dobre boty to nie tylko wyszukiwacze nowości – to także wszelkiego rodzaju oprogramowanie analityczne, pomiarowe. Wszystko to, co sprawdza, jaki jest ruch, ile osób teraz robi to lub tamto. Dzięki nim mogłem podać te dane powyżej na temat statystyk sieci. Tak czy siak, cały ruch dobrych botów to prawie 1 / 3 całego ruchu w w internecie.

Złe boty: kradną, oszukują i psują

Roboty utworzone po to, by wykraść dane, znaleźć niezabezpieczone urządzenia i włamać się na nie, siać spamem, krążą cały czas po sieci i skanują… Spamerskie wyszukują witryny, w których można zostawiać komentarze i dopisują się pod materiałami, załączając linki do zainfekowanych stron lub materiałów. Wykradające informacje próbują hakować urządzenia, wstrzykiwać złośliwy kod, wpinać się w transmisję, by przejąć numer karty kredytowej, itp. Są również boty kradnące kontent, kopiujące go po to, by opublikować na innych stronach czy choćby zeskanować adres e-mail, by zacząć zapychać go spamem. No i są ulubione boty mediów, czyli te, które dokonują ataków na serwisy, by utrudnić ich działanie, spowolnić lub nawet spowodować upadek. Czy za karę za różne, niepopularne działania, czy dla hecy, czy dla… pieniędzy. Bo Upadek na kilka minut dużego serwisu, to ogromne pieniądze, zarobione w tym czasie, przez inne.

“Złe boty” są często charakteryzowane na dobre – udają np. przeszukiwaczy wyszukiwarek. Jak podaje jedno ze źródeł, na które trafiłem, wiele z nich jest rozsyłanych wieczorami i w nocy – gdy ludzie wychodzą z pracy, gdy administratorzy idą do domów i mniej osób czuwa nad bezpieczeństwem sieci. Są one odpowiedzialne za około 20 proc. całego ruchu w sieci.

Roboty, które rozmawiają ze sobą, same kupują reklamy od innych robotów. I same je oglądają

Według Wall Street Journal, istnieje jeszcze jedna grupa botów, która odpowiada za sporą (nawet do około 1 / 3, choć to chyba przegięcie) część ruchu w sieci. Są to boty udające użytkowników. Wysyłane w sieć w konkretnym celu – “klikają” na wskazane strony, generują odsłony, “klikają” w reklamy na nich – wszystko po to, by zawyżyć wartość serwisu dla reklamodawców czy zapewnić konkretny dochód z reklam. Jak pisze WSJ: “Powód jest prosty, w obecnym formacie reklamowym reklamy mają być wyświetlone na stronie, a nie obejrzane przez użytkownika”.

Zauważyć należy, ze przecież roboty wykorzystuje się również do automatycznego tworzenia stron internetowych, wypełnionych ukradzioną skądś (np. z wikipedii) treścią – i wyświetlania w ich obrębie tych reklam oczywiście. Te strony służą zresztą nie tylko wyświetlaniu reklam, ale też pozycjonowaniu innych, ważniejszych stron.

Najciekawsze jest jednak, że serwisy wykorzystują zautomatyzowany proces zamawiania reklam wyświetlanych w serwisach. Inne zaś stosują roboty w celu zlecania wyświetlania takich reklam. W istocie pojawia się sytuacja kuriozalna, oto automaty wykupują reklamy u automatów, a następnie, by spełnić wymogi umów, inne roboty odwiedzają te strony w celu zapewnienia odpowiedniej ilości odsłon.

Roboty, które potrafią siebie zbałamucić… głosem

Na domiar wszystkiego – naukowcy z MIT już jakiś czas temu wykryli złośliwe oprogramowanie, potrafiące użyć syntezatora mowy. Powoduje to, że złośliwe oprogramowanie nie będzie musiało dostać się na urządzenie, by wykraść z niego dane, kazać mu wejść na zainfekowaną stronę, wyłączyć antywirusa czy po prostu je przejąć. W MIT Technology Review znalazłem artykuł, w którym opisano, jak za pomocą syntezatora mowy w Windowsie można nakazać temu systemowi wykonanie komend różnych komend. Przykład: Attack on Windows Speech Recognition. To samo można oczywiście zrobić na smartfonie. Tu mamy przykład sprawdzenia za pomocą mowy i Google Now, gdzie jest urządzenie:

https://www.youtube.com/watch?v=e5zjJgGSUw4

Problem dotyczy zarówno Windows, iOS, Androida, jak i Linuxa. Za pomocą innego urządzenia – komputera, koło którego położysz smartfona; za pomocą smartfona, który pogada z Twoim tabletem, gdy pójdziesz do toalety, za pomocą głosu wygenerowanego przez automat ktoś może nakłonić program obsługujący twoje urządzenie, by zrobił to, czego nie powinien.

Jesteśmy tylko dodatkiem do robotów

Żyjemy w przeświadczeniu, że te miliony czy miliardy stron internetowych, to nasze dzieło i są stworzone dla nas. Myślimy, że lajki pod niektórymi artykułami są wyrazem autentycznej interakcji żywych ludzi. Zlecając reklamę w serwisie tematycznym mamy przeświadczenie, że zobaczą ją żywi ludzie. Pisząc artykuły myślimy, że autentyczni, żywi ludzie je przeczytają.

Na moim blogu mam w ciągu miesiąca kilka do kilkunastu zablokowanych fejkowych spam-komentarzy. Komentarzy, które wychwalają mój wpis pod niebiosa i zachęcają do odwiedzenia swojej strony.

Hi there, I read your blog on a regular basis. Your humoristic style

is witty, keep up the good work!

Hi friends, pleasant paragraph and good arguments commented here,

I am genuinely enjoying by these.

Na Twitterze obserwuje mnie z pewnością kilka fejk – kont.

W 2013 roku według statystyk odpowiadaliśmy za 38,5 proc. ruchu, który dział się w internecie. Być może nie jest jeszcze tragicznie, ale rok wcześniej było to 49 proc.. Udział robotów w ruchu wzrósł w ciągu roku o ponad jedną piątą. I wszystko wskazuje, że w tym roku nie będziemy odpowiedzialni nawet za trzecią część tego, co się dzieje w internecie.

Jeszcze sami piszemy teksty z tytułami i frazami “pod Google”. Jeszcze sami bawimy się w SEO i pozycjonowanie. Jeszcze w większości sami zakładamy strony internetowe. Ale coraz częściej to boty tworzą takie teksty, tworzą fejk-blogi pozycjonujące. A już dawno roboty wyprzedziły nas w czytaniu. Klikają w reklamy. Zostawiają komentarze. Wchodzą w interakcje. Zaczynają rozmawiać same ze sobą.

Już 60% internetu to sieć robotów. Nam coraz częściej pozostaje patrzenie, co jest na pierwszym miejscu w Google. I lajkowanie śmiesznych kotów.

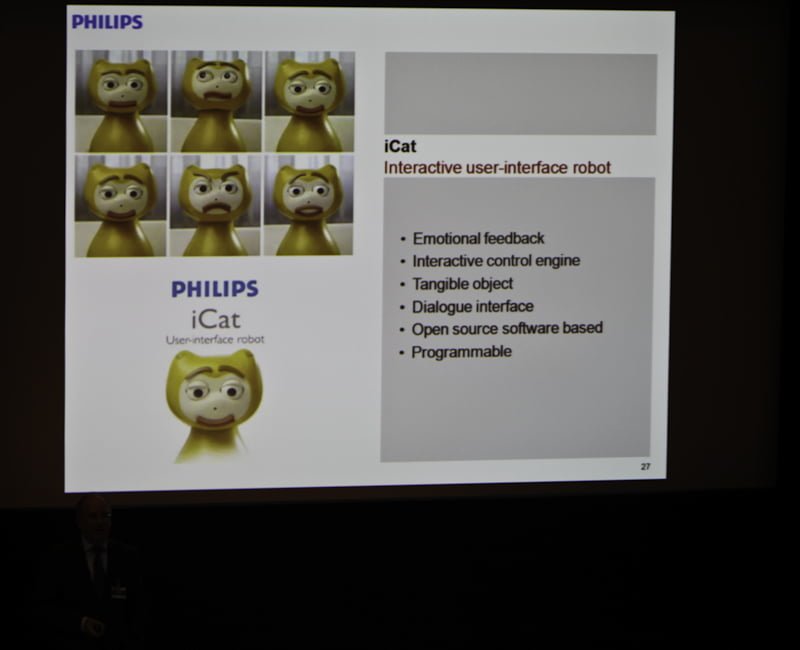

Ewentualnie zabawa z kotami cyfrowymi.