Żyjemy w dziwnych czasach. Już teraz trudno odróżnić rzeczywistość od fantazji, prawdę od kłamstwa, wiarygodną informację od fake newsa. Naukowcy z Uniwersytetu w Waszygtonie nie pomagają: stworzyli narzędzie, które umożliwia szybkie edytowanie klipu wideo, tak by występująca w nim postać poruszała wargami zgodnie z dowolnym materiałem dźwiękowym.

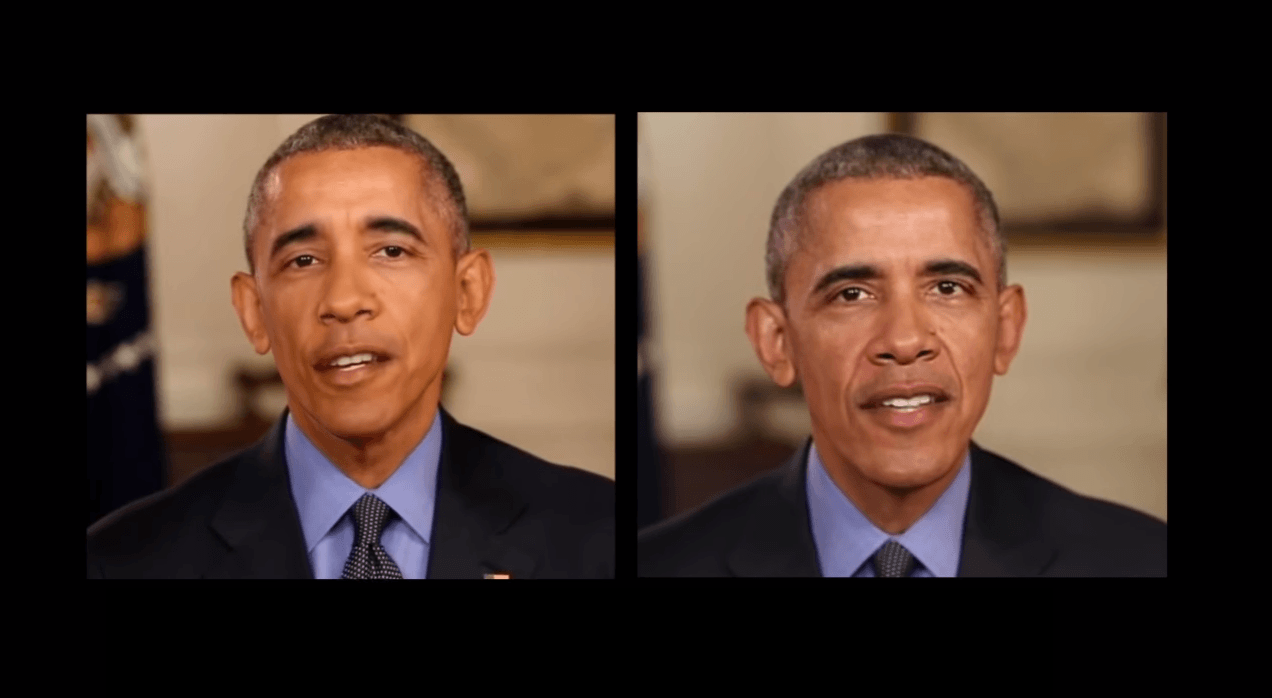

Rezultat przyprawia o dreszcze. Do testów użyto wizerunku Baracka Obamy, ale technologię można zastosować wobec każdego, kogo nagrano choćby średniej jakości kamerą. Naukowcy byli w stanie przekształcić materiał audio i wkomponować go w stary klip wideo. Na filmie Barack Obama zachowuje się niesamowicie realistycznie, a nie mając porównania, trudno nie odnieść wrażenia, że mamy do czynienia z prawdziwym przemówieniem.

Badacze oczywiście uważają, że to świetna sprawa. Że technologia ta będzie miała zastosowanie w efektach specjalnych w filmach lub poprawi jakość wideorozmów. Jest jednak druga, mroczniejsza strona tych eksperymentów.

Wkrótce ten sam system bazujący na sztucznej inteligencji mógłby posłużyć do robienia fałszywych filmów z innymi osobami publicznymi, albo nawet ze zwykłymi ludźmi, takimi jak ja czy ty. Oczywiście bardzo mało prawdopodobne jest, by komukolwiek chciało się zaszkodzić jakiemuś przeciętnemu zjadaczowi chleba, jednak celebryci i politycy mogą być znacznie częściej wybierani jako cele takich ataków.

Zespół badaczy przypuszcza, że system komputerowy mógłby teoretycznie nauczyć się robić lipne wideo na podstawie prawie każdej wypowiedzi.

Jedna uniwersalna sieć mogłaby zostać przeszkolona dzięki dostępowi do wielu filmów z różnymi osobami. Następnie, mając do dyspozycji próbkę wideo mówcy (nawet niskiej jakości), można „włożyć” w jej usta dowolne słowa. Wystarczy, że z wideo pozyskamy dokładny kształt ust danej osoby.

– czytamy w raporcie.

To tylko jeden z wielu projektów, których celem jest „udawanie” człowieka. Sztuczna inteligencja Google DeepMind, potrafi już fabrykować nagrania głosowe, zaś jeden z nowszych programów Lyrebird może skomponować całe zdania na podstawie 60-sekundowej próbki głosu lektora.

Naukowcy z Uniwersytetu w Waszyngtonie twierdzą, że ich system komputerowy mógłby służyć do weryfikacji odwrotnej, czyli pomagać ludziom w określeniu, czy coś jest prawdziwym wideo, czy też efektem pracy programu. Ich wytłumaczenie nie dziwi – całkiem realistyczne odwzorowywanie ludzkich zachowań podczas mowy jest czymś, co czyni to narzędzie potencjalnie niebezpiecznym.

To, że po odpowiedniej analizie bylibyśmy w stanie odróżnić fałszywą wypowiedź jakiegoś polityka od prawdziwej to jedno. Ale kontrowersyjne klipy to coś, co trudno zatrzymać – zwłaszcza w dobie internetu, w którym od podzielenia się jakąś treścią dzielą nas dwa kliknięcia. Wielu ludzi nie zadaje sobie trudu, żeby przeczytać cały wstęp do artykułu i bazuje głównie na tytułach, nie mówiąc już o starannym zapoznaniu się z całą jego treścią. A to jeden z pierwszych filtrów, którym możemy odsiewać fake newsy.

Na razie z pewną dozą niepokoju możemy obserwować postęp w dziedzinie imitowania ludzkiej mowy i łączenia jej z obrazem. Wspomniane narzędzie jeszcze długo nie będzie dostępne publicznie. Ale skoro wiemy o tego typu technologii, wkrótce przyjdzie czas, kiedy będziemy musieli poważnie zastanowić się, czy wywiad, który oglądam, jest prawdziwą informacją czy ktoś ją sfabrykował?

źródło: Mashable