Dzisiejsze superkomputery znacznie przewyższają swoimi możliwościami ogólnodostępne stacje robocze skierowane do sprzedaży masowej. Taka maszyna, aby zasłużyć na swoje miano musi posiadać niewyobrażalną moc obliczeniową. Jej wydajność mierzona jest TFLOPS-ach. Niestety, w parze z mocą idą też potężne wymiary. Technika wciąż dąży do miniaturyzacji procesu litograficznego. Obecne superkomputery już nie zajmują dwóch hangarów, a wysłużone PC-ty przez przeciętnego użytkownika zostały zamienione na bardzo poręczne ultrabooki czy „mobilne” tablety. Dynamika rozwoju jest tak wielka, że daleko nam do rozważań na temat końca wyścigu zbrojeń. Czy jednak możemy być spokojni o przyszłość przenośnych komputerów? Zdania analityków są podzielone.

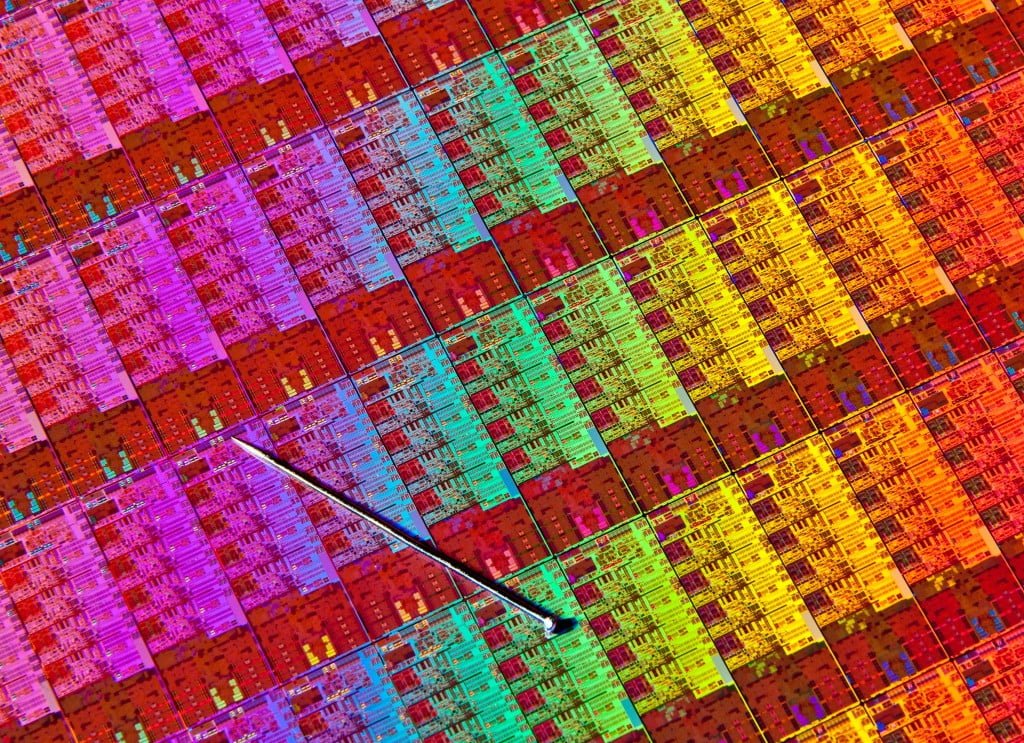

Oderwijmy się na chwilę od sektora mobilnego i popatrzmy na sytuację w krainie większych braci. Układy SoC komputerów obecnych w naszych czasach, oparte są o krzem. Pierwiastek, bez którego praca z dzisiejszymi PC-towymi pomocnikami w takiej formie, byłaby niemożliwa. Od czasów wykorzystania krzemu w elektronice, nauka nie wynalazła niczego lepszego. Pracę nad nowymi, grafenowymi układami są w powijakach. Bardziej można nazwać je wizją naukowców, niż realnym rozwiązaniem, które można wprowadzić do masowej produkcji. Tymczasem świat dynamicznie idzie do przodu. Żadna dziedzina nauki nie rozwija się tak mocno, jak informatyka. Powstają coraz szybsze procesory, pamięci RAM, interfejsy przy jednoczesnym zmniejszeniu objętości całych układów. Proces rosnących możliwości współczesnych komputerów determinuje osławione prawo Moore’a. Żyjący do dziś legendarny współzałożyciel Intela, Gordon Moore w 1965 roku odkrył, że istnieje zależność pomiędzy ilością tranzystorów a rozpiętością czasu potrzebnego na wymyślenie kolejnych układów. Dokładniej rzecz ujmując, ilość tranzystorów umieszczonych na układach SoC ( bardziej szczegółowo – mikroprocesorach), podwaja się z każdym rokiem. Dziesięć lat później teoria ta została skorygowana przez samego pomysłodawcę, a czas potrzebny na wymyślenie układu o podwojonej liczbie tranzystorów wynosił od tamtej pory w przybliżeniu 24 miesiące. Ostateczny kompromis osiągnięto przy wartości równej 18 miesięcy, czyli ni mniej, ni więcej – 1,5 roku. Pomimo, coraz częstszych głosów o upadłości tego prawa, obowiązuje ono do dziś. No właśnie. Mamy 2014 rok i przyrost wiedzy oraz możliwości rośnie w zastraszającym tempie. Jak długo inżynierowie będą w stanie podwajać ilość tranzystorów tak, aby zachować chociaż minimalny wzrost mocy obliczeniowej? Jak długo istnienie krzemowych układów będzie mieć sens, skoro powierzchnia jest ograniczona i ciężko upychać tranzystory w nieskończoność? Procesory Intel Haswell mają ich aż 1,4 mld. Ile jeszcze będziemy mogli mówić o innowacyjności współczesnych układów SoC, podczas gdy proces litograficzny zmniejsza się w zastraszającym tempie? Wymusza to przede wszystkim sektor urządzeń mobilnych, który dąży do miniaturyzacji komputerów. Dokładnie Wam nie odpowiem, ale czasu zostało niedużo. Sam Michio Kaku – popularny fizyk teoretyczny i kosmolog, uważa, że zostało nam mniej więcej 8 lat i w 2022 roku krzem osiągnie swoje końcowe możliwości rozwoju. Oznacza to, że obowiązujące od niespełna 50 lat prawo, stanie się martwe. Choć spekulacje na ten temat trwają od dawna, to i tak nie ma wątpliwości, że będzie to ważne wydarzenie, które może odwrócić przyszłość elektroniki do góry nogami.

Czym jest ten wspaniały krzem i jaką wartość stanowi?

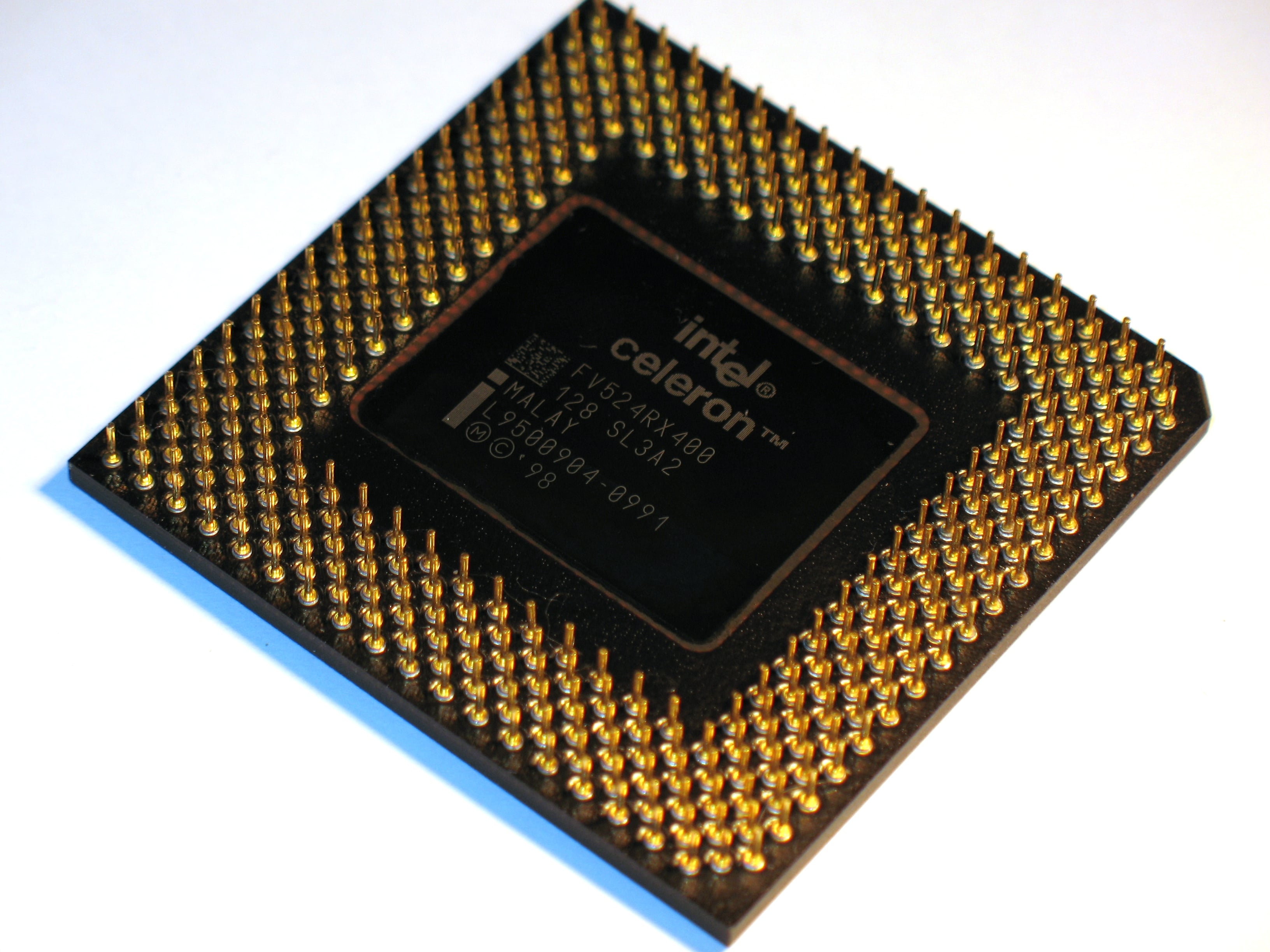

Krzem – to jeden z pierwiastków znajdujących się na naszym globie. Jest często spotykany. Składa się z niego aż ¼ skorupy ziemskiej. Dzięki właściwościom półprzewodnikowym znalazł szerokie zastosowanie w elektronice. Oczywiście specjalne płytki krzemowe są dokładnie oczyszczane i odpowiednio przygotowane do użytku. Po specjalnej obróbce (pomijam tu kolejne złożone etapy) otrzymujemy mikroprocesor, którego najprostszym i najmniejszym elementem jest tranzystor. Spełnia on rolę tzw. „przełącznika” w procesie przepływu prądu elektrycznego w układzie mikroprocesora.

Nie będę jednak wykładał Wam tu całej fizyki i chemii, gdyż temat artykułu prowadzi w innym kierunku. Krótka wstawka na temat krzemu była po to, by unaocznić jak genialne właściwości ma ten pierwiastek. W zasadzie do dziś go nie zastąpiono w masowym zastosowaniu szeroko pojętej elektroniki. Cały czas jest on najtańszym i zarówno najlepszym zminiaturyzowanym półprzewodnikiem prądu, jaki zdołano wprowadzić. Co prawda istnieją prace badawcze nad innymi technologiami, o których napiszę niżej. Są one jednak w powijakach i napotykają kolejne problemy uniemożliwiające zastosowanie. Tranzystory krzemowe w chwili powstania miały swój niewątpliwy potencjał. Ponieważ krzemu jest dużo, zasoby wydają się być niemal niewyczerpalne.

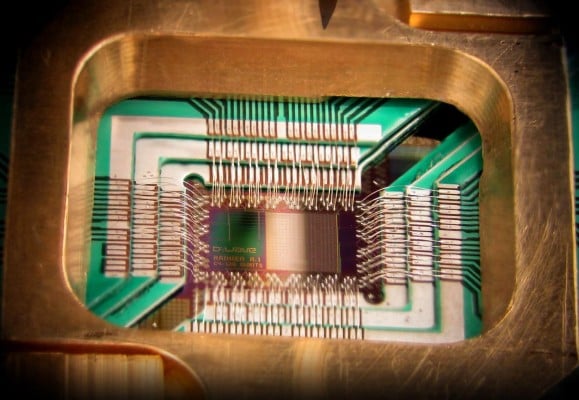

Od tego pierwiastka swój początek miała Dolina Krzemowa, która uznawana jest za centrum przemysłu komputerowego. Nigdzie na świecie nie ma takiej ilości firm skumulowanej na jednym terenie, zajmujących się badaniami, rozwojem i produkcją technologii półprzewodników opartych o krzem.

Zastosowanie i potencjał tego pierwiastka pozostaje bezdyskusyjny. Gdy jednak emocje już opadną widać, że genialny wynalazek ludzkości, nie jest taki idealny. Mimo, że z powodzeniem budowane są kolejne układy, to na przykładzie Ivy Bridge i Haswell (kolejnych generacji procesorów Intela) doskonale widać, że tempo rozwoju komputerów stacjonarnych i laptopów powoli wyhamowuje. Winę za to ponosi miniaturyzacja. Ilość tranzystorów upchana na małej powierzchni też przestaje być opłacalna. Gdzie zatem istnieje złoty środek? Przekonamy się w najbliższej przyszłości…

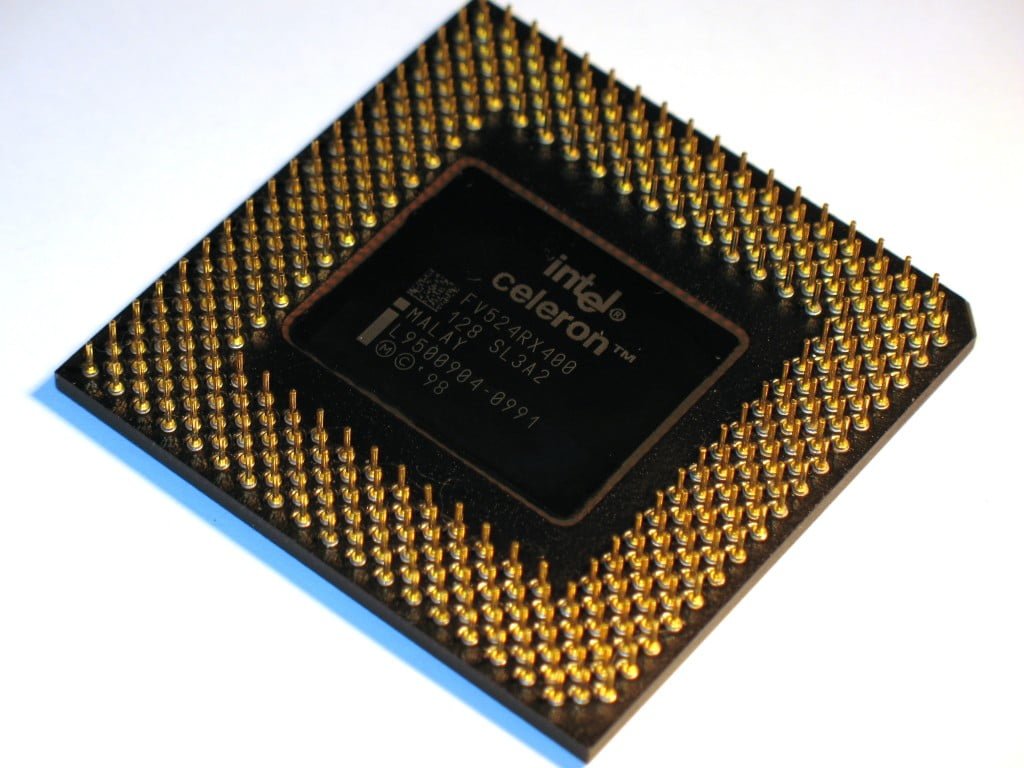

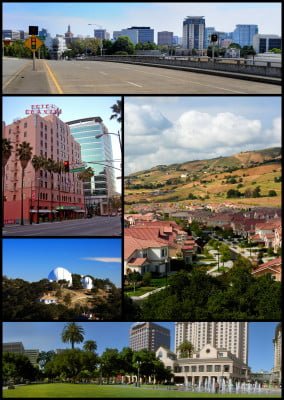

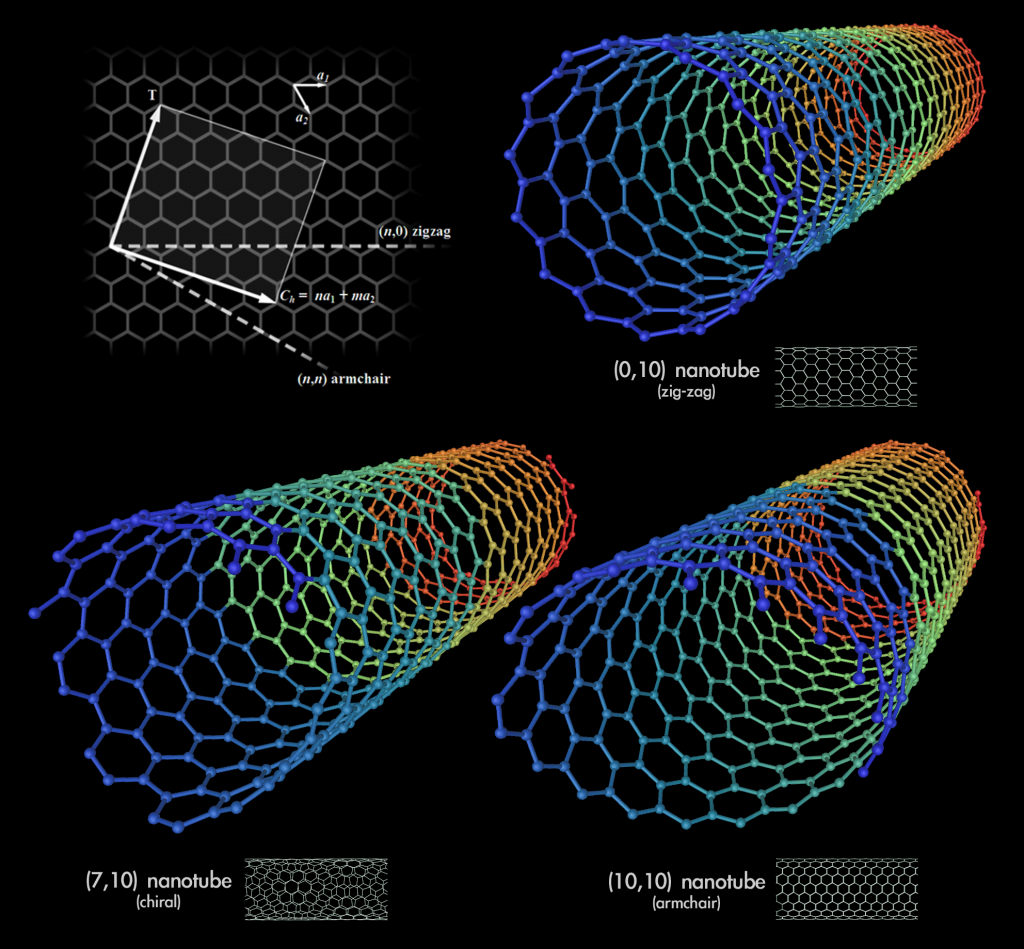

Znaczenie grafenu

Kolejnym etapem i normalnym biegiem ewolucji jest wprowadzanie nowych technologii. Dotychczasowe układy krzemowe przez blisko 50 lat spełniały swoją rolę. Czas jednak na coś innowacyjnego. Pierwsze, co przychodzi mi na myśl, to grafen. W ostatnim artykule wspomniałem o nim w kontekście baterii. Sami doskonale rozumiecie, że postęp ten, jeśli dojdzie do skutku, zrewolucjonizuje urządzenia mobilne. Zapewniając 10-krotne możliwości dotychczasowych akumulatorów Li-Ion i skracając czas ładowania do zaledwie kwadransa, grafen stanie się pierwszym, który zerwie kajdany zniewolenia urządzeń mobilnych i uniezależni nas od gniazdka elektrycznego. Ale jakie on ma przełożenie na układy SoC? Otóż bardzo duże. Pomijając szczegółową książkową teorię, wynalazek ten to – jednoatomowa cząsteczka węgla, posiadająca tylko dwa wymiary. W odniesieniu do procesorów, struktury grafenowe miałyby stanowić warstwę cylindryczną nanorurek węglowych nowych tranzystorów. Na takiej technologii opierać się będzie terminal przyszłości. Mowa o komputerze kwantowym. Wiem, że wydaje Wam się to niezwykle naukowe wyłożenie wiedzy, jednak bez tego nie wyjaśnię możliwości grafenu. Wracając do tematu. Na świecie powstał już prosty komputer kwantowy – Cedric. Jego autorami są badacze z kalifornijskiego Uniwersytetu Stanforda. Naukowcy twierdzą, że to właśnie urządzenia oparte o nanorurkowe mikroprocesory stanowią przyszłość informatyki i komputeryzacji. Panuje też opinia, że grafenowe procesory wyprą powszechnie dziś stosowany krzem. Możliwości takiego urządzenia kwantowego są ogromne. Dzięki zastosowaniu nanorurek wydajność procesorów może sięgać kilkuset GHz, a w przyszłości nawet i THz (tysiąc GHz)! Skąd takie osiągi? Biorą się one z właściwości kubitu – podstawowej jednostki informacji w komputerach kwantowych. Współczesne komputery działają w systemie binarnym (dwójkowym). Pojedynczy bit opiera swoje działanie na dwóch operacjach ujętych w cyfrach 0 i 1. W przypadku „0” procesor nie reaguje, zaś „1” oznacza sygnał do działania. Natomiast, kubit nie przyjmuje żadnej z tych dwóch jednostek. Po prostu obiera wartości pośrednie, zarówno 0 jak i 1. W konsekwencji terminal kwantowy umożliwia przeprowadzenie wielu operacji naraz. To ogromny skok technologiczny! Zauważmy, że krzem źle znosi wysokie częstotliwości taktowania zegara. W przypadku grafenu, problem ten nie występuje. Innymi słowy – współczesny komputer nie pozwala na tak daleko posuniętą wielowątkowość, co technologia kwantowa. Zdaniem naukowców, Cedric wyprzedza obecną krzemową technologię, o co najmniej 10 lat. Trzeba sobie jednak zdawać sprawę, że istnieje wiele ograniczeń. Po pierwsze, obecne układy tranzystorowe z nanorurek węgla w temperaturze pokojowej działają krótko. Dotychczas prototypowy komputer kwantowy utrzymywał stabilność systemu przez zaledwie 39 minut. Po drugie, kwantowa technologia jest wciąż niestabilna. Część nanorurek nie zachowuje swoich właściwości półprzewodnikowych, wpuszczając przepływ prądu w sposób stały (bez możliwości odcięcia). Po trzecie, koszty produkcji, a także dostępne formy i technologie wykonania, są mało wydajne. Potrzebna jest nowa infrastruktura, aby produkcja komputerów kwantowych była opłacalna. Pomimo, że długa droga przed ludzkością, jako informatyk wierzę w powodzenie tej technologii.

Kolejnym etapem i normalnym biegiem ewolucji jest wprowadzanie nowych technologii. Dotychczasowe układy krzemowe przez blisko 50 lat spełniały swoją rolę. Czas jednak na coś innowacyjnego. Pierwsze, co przychodzi mi na myśl, to grafen. W ostatnim artykule wspomniałem o nim w kontekście baterii. Sami doskonale rozumiecie, że postęp ten, jeśli dojdzie do skutku, zrewolucjonizuje urządzenia mobilne. Zapewniając 10-krotne możliwości dotychczasowych akumulatorów Li-Ion i skracając czas ładowania do zaledwie kwadransa, grafen stanie się pierwszym, który zerwie kajdany zniewolenia urządzeń mobilnych i uniezależni nas od gniazdka elektrycznego. Ale jakie on ma przełożenie na układy SoC? Otóż bardzo duże. Pomijając szczegółową książkową teorię, wynalazek ten to – jednoatomowa cząsteczka węgla, posiadająca tylko dwa wymiary. W odniesieniu do procesorów, struktury grafenowe miałyby stanowić warstwę cylindryczną nanorurek węglowych nowych tranzystorów. Na takiej technologii opierać się będzie terminal przyszłości. Mowa o komputerze kwantowym. Wiem, że wydaje Wam się to niezwykle naukowe wyłożenie wiedzy, jednak bez tego nie wyjaśnię możliwości grafenu. Wracając do tematu. Na świecie powstał już prosty komputer kwantowy – Cedric. Jego autorami są badacze z kalifornijskiego Uniwersytetu Stanforda. Naukowcy twierdzą, że to właśnie urządzenia oparte o nanorurkowe mikroprocesory stanowią przyszłość informatyki i komputeryzacji. Panuje też opinia, że grafenowe procesory wyprą powszechnie dziś stosowany krzem. Możliwości takiego urządzenia kwantowego są ogromne. Dzięki zastosowaniu nanorurek wydajność procesorów może sięgać kilkuset GHz, a w przyszłości nawet i THz (tysiąc GHz)! Skąd takie osiągi? Biorą się one z właściwości kubitu – podstawowej jednostki informacji w komputerach kwantowych. Współczesne komputery działają w systemie binarnym (dwójkowym). Pojedynczy bit opiera swoje działanie na dwóch operacjach ujętych w cyfrach 0 i 1. W przypadku „0” procesor nie reaguje, zaś „1” oznacza sygnał do działania. Natomiast, kubit nie przyjmuje żadnej z tych dwóch jednostek. Po prostu obiera wartości pośrednie, zarówno 0 jak i 1. W konsekwencji terminal kwantowy umożliwia przeprowadzenie wielu operacji naraz. To ogromny skok technologiczny! Zauważmy, że krzem źle znosi wysokie częstotliwości taktowania zegara. W przypadku grafenu, problem ten nie występuje. Innymi słowy – współczesny komputer nie pozwala na tak daleko posuniętą wielowątkowość, co technologia kwantowa. Zdaniem naukowców, Cedric wyprzedza obecną krzemową technologię, o co najmniej 10 lat. Trzeba sobie jednak zdawać sprawę, że istnieje wiele ograniczeń. Po pierwsze, obecne układy tranzystorowe z nanorurek węgla w temperaturze pokojowej działają krótko. Dotychczas prototypowy komputer kwantowy utrzymywał stabilność systemu przez zaledwie 39 minut. Po drugie, kwantowa technologia jest wciąż niestabilna. Część nanorurek nie zachowuje swoich właściwości półprzewodnikowych, wpuszczając przepływ prądu w sposób stały (bez możliwości odcięcia). Po trzecie, koszty produkcji, a także dostępne formy i technologie wykonania, są mało wydajne. Potrzebna jest nowa infrastruktura, aby produkcja komputerów kwantowych była opłacalna. Pomimo, że długa droga przed ludzkością, jako informatyk wierzę w powodzenie tej technologii.

Kres prawa Moore’a

Wróćmy jednak na ziemię. Póki co, technologie kwantowe są nutą przyszłości. Musimy się skoncentrować na tym, co mamy dostępne teraz. Wspaniały wynalazek ludzkości – układ scalony oparty o krzem, przeszedł wielką ewolucję. Od momentu, w którym powstał pierwszy procesor, aż do dziś możemy powiedzieć, że minęło kilka epok w świecie informatyki. Wszystko jednak co piękne z czasem ma swój koniec. Era oparta o dotychczasowe technologie nie może trwać wiecznie. Wiedział o tym sam Gordon Moore, wiedzą i współcześni inżynierowie, którzy borykają się z coraz większymi ograniczeniami. Trudniejszy niż kiedyś proces poprawy wydajności współczesnych terminali, poprzez upchanie większej ilości tranzystorów, przestaje być opłacalny. Biorąc pod uwagę to, o czym pisałem wyżej – teoria legendarnego twórcy potęgi Intela traci sens. Pomimo, że giganci rynku w najlepsze realizują wieloletnie plany technologiczne, któregoś dnia, prezesi liczących się korporacji będą musieli skapitulować. Oznajmią światu, że ich możliwości tworzenia innowacyjnych układów SoC opartych o krzem, skończyły się. Bez znaczenia czy będzie to okres, w którym ogólnodostępna idea komputerów kwantowych znajdzie zastosowanie, czy będzie to brak jakiejkolwiek alternatywy. Koniec innowacyjności najbardziej rozwijanego sektora – przemysłu komputerowego, będzie wydarzeniem na miarę epoki. A co wtedy? Szara rzeczywistość… Mocno napędzany rynek straci na wartości. Zanim nowa technologia zyska zaufanie klientów, a przede wszystkim koncernów produkujących takie układy, upłynie trochę czasu. Powstanie rynkowa próżnia. A jak wiadomo, przestój technologiczny nigdy nie wróżył niczego dobrego. Z punktu widzenia ekonomicznego, jest to klęska.

Proces litograficzny, a efektywność tranzystorów krzemowych

Każdy, kto poznał już prawo Moore’a, doskonale wie, że wydajność nowych układów determinuje coraz większa ilość tranzystorów użytych przy produkcji danego procesora. Tacy giganci jak Intel czy AMD doskonale zdają sobie sprawę z tego, że ilość już upchanych krzemowych „wafli” przypadających na jeden układ, jest spora. Wiedzą także o tym, że zbliżają się do momentu, w którym na kolejne tranzystory braknie po prostu miejsca. Są również opinie, że ilość zastosowanych krzemowych elementów w odniesieniu do jednego procesora, przestanie być opłacalna. Ale o tym napiszę nieco później.

Przejdźmy teraz do myśli przewodniej akapitu. Wielki „boom” na dotykowe urządzenia mobilne spowodował, że firmy produkujące układy SoC zaczęły kombinować. Aspektów, które wymagały udoskonalenia było wiele. Duży proces technologiczny pochłaniał spore ilości energii. O ile w komputerach stacjonarnych nie miało to większego znaczenia, to tablety czy smartfony potrzebowały solidnego ogniwa zasilającego urządzenie. Jak mogliście przeczytać z ostatniego mojego artykułu, technologia dzisiejszych akumulatorów jest – delikatnie mówiąc – mało wydajna. Naukowcy poszli więc tropem energooszczędności. Redukcję zapotrzebowania na energię opracowano dwufazowo. Z jednej strony zmniejszany jest proces technologiczny. Po czym, aby zwiększyć efektywność, układy i moduły łączności implementowane w urządzeniu są udoskonalane. W rezultacie całość pobiera mniej prądu. W rzeczywistości jednak ani tablety, ani smartfony, ani tym bardziej ultrabooki nie „trzymają” dłużej na jednym cyklu ładowania. Powodem jest wszechobecna pogoń za kasą. Marketing napędza sprzedaż, a ta jest wysoka. Ponieważ kolejne generacje są mocniejsze, wydajniejsze, wspanialsze producenci piorą mózgi potencjalnym klientom. Moc urządzeń mobilnych nie zawsze przez kupującego jest wykorzystywana, a baterie, jak były słabe, tak są dalej. Na ludzi działają cyferki, a nie zdrowy rozsądek, więc postęp jest pozorny.

Nie schodźmy jednak z tematu. Koncentrując swoją uwagę na obniżeniu procesu technologicznego, wedle założeń potentatów rynku, ma on przynieść zmniejszenie rozmiarów całego układu SoC. Wraz z tym idzie mniejszy pobór prądu. Zatem droga rozwoju firm wyznaczających trendy jest właściwa. I nawet nie poruszyłbym tego aspektu, gdyby nie jedna rzecz. Rozwój technologiczny determinuje prawo Moore’a. Intel czy AMD idąc tym tropem, wprowadzają swoje kolejne rozwiązania starając się zwiększyć wydajność procesorów. W tym celu upychają większą ilość tranzystorów w układzie mikroprocesora. Jednocześnie przy coraz niższej litografii ilość krzemowych „wafli” wzrasta. Okazuje się jednak, że ciaśniej upchane i bardziej kompaktowe tranzystory nie dają tak oczywistego przyrostu mocy, a cena układów rośnie. Między Ivy Bridge a Haswell różnica wydajności wynosi zaledwie 5-10%. W przeciwieństwie do nich druga generacja procesorów Intela – Sandy Bridge, ze swobodnie umieszczonymi krzemowymi elementami, dała aż 60% wzrost osiągów w stosunku do poprzednika. Nawet główny inżynier AMD, zauważył te problemy. W jednym z wywiadów powiedział:

„Jeżeli upakujesz za mało tranzystorów, chip będzie kosztował za dużo w przeliczeniu na tranzystor, ale jeżeli przesadzisz w drugą stronę, będzie tak samo. Czekając na przejście z technologii 28 nm na 20 nm okazało się, że zajęło to dłużej niż mogłoby wynikać z prawa Moore’a.”

Choć AMD wiecznie depcze ślady Intela, to ze słów Gustaffsona można wyczytać, że technologia krzemowa zderzyła się ze ścianą nie do przejścia. Lider rynku ratując sytuację stworzył nowej generacji tranzystor 3D – Tri Gate Transistor. Oferuje on 30% więcej mocy, niż zwykły odpowiednik. Jednak wynalazek ten nie jest rozwiązaniem na dłuższą metę.

Ciężko przypuszczać, że kolejne zejścia procesu technologicznego coś zmienią w tej kwestii. W tym momencie walka toczy się o zachowanie jak największej ilości energii, efektywność i udoskonalenie tego, co zostało wynalezione. Intel oczywiście planuje zejść do 14 nm, potem 10nm i 7nm, aby proces miniaturyzacji zakończyć na 5 nm. Wszystko jest oczywiście z myślą o urządzeniach mobilnych. Wymagają one systematycznego pomniejszania dzisiejszych układów. Ponadto, przy mało wydajnym akumulatorze, często nie są w stanie wytrzymać na baterii do wieczora. W przypadku ultrabooków opartych o mocne podzespoły, nie możemy nawet mówić o takich osiągach. Jednak czy Intelowi uda się ta sztuka, tego nie wiedzą nawet ich inżynierowie. Data premiery przyszłych układów nie została podana (jest tylko termin orientacyjny). Może się okazać, że architektury 5, 7 i 10 nm są tylko czysto teoretyczne. Jestem oczywiście pełen nadziei i z racji dokonań Intela wierzę w jego sukces, ale w praktyce może być różnie. Oczywiście tak drastyczne obniżenie procesu technologicznego daje niesamowite możliwości, których już tu nie przytoczę. Choć czasem czuję, że to jedynie pobożne życzenie naukowców. Ważna uwaga. Rozgraniczam tutaj rozwiązania czysto przenośne od desktopowych. Wiadomo, że producenci stricte mobilnych układów SoC (Qualcomm, ARM, MediaTek) będą w stanie osiągnąć niższą litografię. Nie tędy jednak droga. Całemu światu zależy, by dzisiejsze komputery z powodzeniem przenieść na powierzchnie tabletów, a nawet smartfonów. Bez wydajnych jednostek Intela o takiej możliwości możemy tylko pomarzyć…

Ciężko przypuszczać, że kolejne zejścia procesu technologicznego coś zmienią w tej kwestii. W tym momencie walka toczy się o zachowanie jak największej ilości energii, efektywność i udoskonalenie tego, co zostało wynalezione. Intel oczywiście planuje zejść do 14 nm, potem 10nm i 7nm, aby proces miniaturyzacji zakończyć na 5 nm. Wszystko jest oczywiście z myślą o urządzeniach mobilnych. Wymagają one systematycznego pomniejszania dzisiejszych układów. Ponadto, przy mało wydajnym akumulatorze, często nie są w stanie wytrzymać na baterii do wieczora. W przypadku ultrabooków opartych o mocne podzespoły, nie możemy nawet mówić o takich osiągach. Jednak czy Intelowi uda się ta sztuka, tego nie wiedzą nawet ich inżynierowie. Data premiery przyszłych układów nie została podana (jest tylko termin orientacyjny). Może się okazać, że architektury 5, 7 i 10 nm są tylko czysto teoretyczne. Jestem oczywiście pełen nadziei i z racji dokonań Intela wierzę w jego sukces, ale w praktyce może być różnie. Oczywiście tak drastyczne obniżenie procesu technologicznego daje niesamowite możliwości, których już tu nie przytoczę. Choć czasem czuję, że to jedynie pobożne życzenie naukowców. Ważna uwaga. Rozgraniczam tutaj rozwiązania czysto przenośne od desktopowych. Wiadomo, że producenci stricte mobilnych układów SoC (Qualcomm, ARM, MediaTek) będą w stanie osiągnąć niższą litografię. Nie tędy jednak droga. Całemu światu zależy, by dzisiejsze komputery z powodzeniem przenieść na powierzchnie tabletów, a nawet smartfonów. Bez wydajnych jednostek Intela o takiej możliwości możemy tylko pomarzyć…

Umarł król, niech żyje król

Co w tym momencie bym nie napisał, krzem powoli traci swą innowacyjność. Jak z każdą technologią bywa, przychodzi moment, w którym trzeba ją zastąpić nowszym rozwiązaniem. Tradycyjny tranzystor wyczerpał swoje możliwości. Pora na jego grafenowego odpowiednika. Naukowcy, jak i cały świat techniki, pokładają ogromne nadzieje w tym świetnym wynalazku. Nie można jednak spoczywać na laurach. Komputer kwantowy jest jeszcze we wczesnej fazie rozwoju. Dużo wody w Wiśle może upłynąć, zanim ukaże się finalna, w pełni stabilna wersja. Pozostaje nam jedynie czekać na rozwój wydarzeń, ale myślę, że jest na co. Terminal oparty na grafenowych tranzystorach osiąga moc, o której współczesne komputery mogą pomarzyć. Jeszcze piękniej wygląda przyszłość, gdy dołożymy do tego rozbudowaną wielowątkowość tego układu. Żeby zobrazować Wam bardziej ten przeskok technologiczny, zestawię ze sobą małe, miejskie auto – Fiata Seicento i sportowego, ekskluzywnego Bugatti Veyrona. Oczywiście na obu samochodach pojeździmy, ale jakość i wrażenia z jazdy będą nieporównywalne. Podobnie sprawa ma się z komputerem krzemowym i kwantowym. Piszę o tym, dlatego, że jest to niewyobrażalna szansa na pozbycie się wielu ograniczeń. Przeciętna osoba posiadająca taki sprzęt mogłaby być elastyczna. Wcale nie uzależniając swoich codziennych czynności od ciągłego ładowania akumulatora, bądź przesiadania się na stację roboczą, która dostarcza odpowiedniej mocy obliczeniowej do skomplikowanych zadań. Kluczowy jednak nie jest klient indywidualny, a organizacje, które potrzebują zaawansowanego sprzętu o największych możliwych osiągach. Nie bez powodu pisałem na wstępie o superkomputerach. Ich rozwój i sens istnienia, a także należyte wykorzystanie, zależą w głównej mierze od powodzenia grafenowych układów. Teraz zajmuje sporą powierzchnię, ale w perspektywie kwantowego komputera nie będzie to mieć racji bytu. I dobrze. Wszak uważam, że sceny rodem ze Star Treka czy innych filmów Sci-Fi wcale nie muszą być nierealnym marzeniem. Być może z pomocą tak zaawansowanej, sztucznej inteligencji rozwój nauki znacznie by przyśpieszył. Lecz to już odległa polemika…

Czy mobilne urządzenia podzielą los większych braci?

Przyszłość krzemu maluje się w czarnych barwach. Choć nie można powiedzieć, że w momencie wejścia na rynek kwantowego odpowiednika, tradycyjny komputer przestanie istnieć. To mam wrażenie, że cały ciężar oparty na obecnej technologii pójdzie z dymem. Ciekawi mnie, co w obliczu takiego scenariusza myślą sobie firmy „zamieszkujące” Dolinę Krzemową. Czy wejście grafenu sprawi, że ktoś z góry przemianuje to technologiczne zagłębie? Czy jednak miejsce to straci swój czar i możliwości?

Przyszłość krzemu maluje się w czarnych barwach. Choć nie można powiedzieć, że w momencie wejścia na rynek kwantowego odpowiednika, tradycyjny komputer przestanie istnieć. To mam wrażenie, że cały ciężar oparty na obecnej technologii pójdzie z dymem. Ciekawi mnie, co w obliczu takiego scenariusza myślą sobie firmy „zamieszkujące” Dolinę Krzemową. Czy wejście grafenu sprawi, że ktoś z góry przemianuje to technologiczne zagłębie? Czy jednak miejsce to straci swój czar i możliwości?

Naprawdę ciężko wydać teraz odpowiedni osąd. Przyszłość to nadal wypadkowa sukcesów i klęsk naukowców. Jedno jest jednak pewne. Im dłużej świat będzie bazował na wysłużonej technologii, tym problemy będą się pogłębiać. Ludzkość oczekuje zmian. Gdy prawo Moore’a stanie się martwe, technika będzie musiała znaleźć sobie inny cel. Pompowanie pieniędzy w kolejne układy „bez” przyszłości może okazać się iście wątpliwe. Rozwijanie tego, co nie przyniesie oczekiwanego skutku to strata czasu i nie ukrywajmy, również kasy. Jednocześnie idea mobilnych superkomputerów znacznie się oddala.

Przenieście się myślami w przyszłość. Wyobraźcie sobie tablet, który pracuje z prędkością 300 GHz i spokojnie wykonuje wszystkie zadania współczesnych komputerów i to z „zamkniętymi oczami”! Piękna wizja prawda? Chyba każdy chciałby mieć taką maszynę zawsze pod ręką. Obecnie mam wrażenie, że dzisiejsze urządzenia mobilne kręcą się w kółko. Wymiana stacjonarnych komputerów w ogóle mija się z celem. Wydźwięk tego faktu jest ogromny. Dziś z powodzeniem odpalimy super wydajne gry na sprzęcie sprzed 5 lat. Oczywiście na niższych detalach, ale jednak. Co kiedyś było po prostu niemożliwe. Chociaż do końca nie wiem czy jest sens rozpatrywać to jednostronnie – jako klęskę. Być może zanim krzem wyczerpie swoje możliwości komputery kwantowe wejdą w finalny etap rozwoju. Z drugiej strony gdyby jednak nie pozostała żadna alternatywa, naukowcy mocniej skupiliby się na innych aspektach, jak akumulator czy stabilność modułów. Efekt takiej pracy przyniósłby wymierne korzyści. Bardzo młody sektor mobilny wymaga zmian. Inżynierowie i badacze mają, nad czym pracować. Sporo wad obecnych tabletów nie powinna mieć racji bytu. Kres możliwości krzemu okazuje się łamać zęby dzisiejszym naukowcom. Choć mam wrażenie, że gdyby skoncentrowali się na tym, co ważne, problemy można by rozwiązać. Pytanie tylko czy technologia liczy się dla człowieka bardziej, niż pieniądze…

Fot. by wikipedia.org (CC) – mikroprocesor, Dolina Krzemowa, nanorurka, procesor kwantowy, procesor Haswell, mikroarchitektura Haswell, układ scalony, superkomputer Titan